点击返回主目录:【目录】FineChatBI

点击返回主目录:【目录】FineChatBI1. 概述编辑

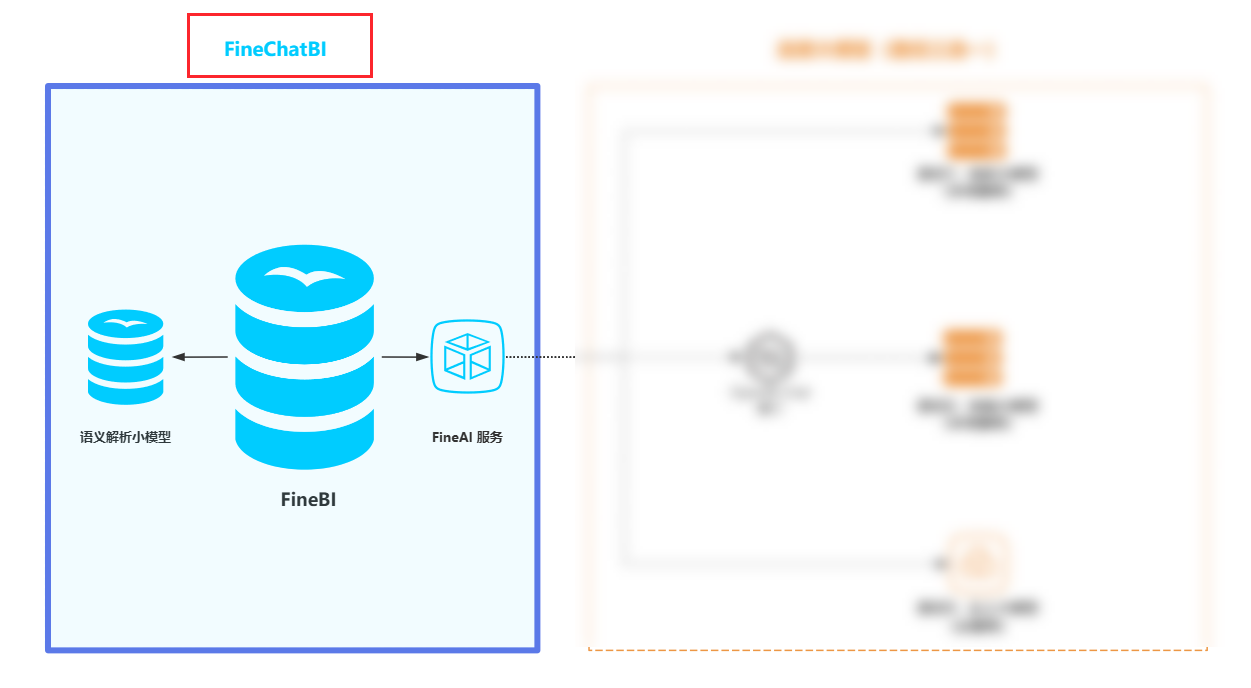

本文将介绍如何部署 FineChatBI 。

1)FineChatBI 以 FineBI 为底座进行分析,所以需要先准备一台 FineBI 工程。

2)部署语义解析小模型:用户提出的问题通过语义解析小模型转化成可执行的数据查询语句,是 FineChatBI 功能的核心。

3)部署 FineAI:FineAI 作为算法工具以及承担大模型转发工作

4)安装问答 FineChatBI 插件。

2. 环境要求编辑

若将三项全部部署在同一台服务器,或者将其中两项部署在同一台服务器,服务器的内存和硬盘资源需求需进行累加计算,其他配置项则选最高配置。

| 资源项 | 配置要求 |

|---|---|

| 部署 FineBI V6.1 及以上版本 | 参考 确认FineBI项目服务器配置 完成服务器选型 计算规则:将 FineChatBI 的用户算作 FineBI 的编辑用户计算服务器所需资源,额外预留 10% 的服务器资源用于 FineChatAI 的使用

|

| 部署语义解析小模型 | Linux 内核版本:3.10 以上 Docker:20.0.0 及以上 |

| 部署 FineAI | Linux 内核版本:3.10 以上 位数:64 位 核数:最低 4 核,推荐 8 核 内存:8G 硬盘:20G 显卡:可无显卡,推荐 4090 Docker:20.0.0 及以上 |

3. 部署语义解析小模型编辑

在为语义解析小模型准备的服务器环境中执行本节操作。

获取语义解析小模型的部署资源:

| 资源 | 获取渠道 |

|---|---|

| 镜像文件 | 语义解析小模型镜像文件 |

| 代码包 | 下载代码包 |

3.1 安装 Docker

安装步骤中需要使用到 Docker,请先检查服务器中是否已完成安装 Docker,检查 Docker 命令:docker --version

若没有安装则会显示 command not found,如下图所示,此时则需要在服务器上安装 Docker,安装步骤可参考:Linux系统在线安装Docker

![]()

若已安装则会显示 Docker 的版本信息,如下图所示:

![]()

3.2 安装镜像

0)(可选)镜像文件完整性校验

安装镜像过程失败时,可查看镜像文件 md5 码和本文档是否一致,若不一致则需要重新下载文件。

示例代码:md5sum fine-chat-bi-parser-base_v1_6.tar

| 镜像文件名 | md5 校验码 |

|---|---|

| fine-chat-bi-parser-base_v1_6.tar | a4b82e5ea243fa7acd9aa6771eb55810 |

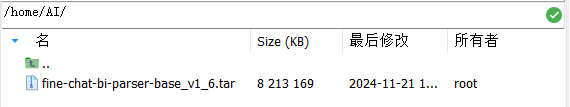

1)将 「镜像」上传到服务器中指定的文件夹中

示例上传文件夹路径为:/home/AI

注:直接上传,上传后不要解压!!!

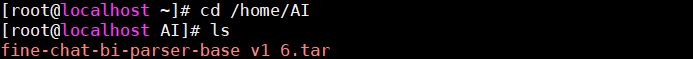

2)使用命令进入到文件夹路径,命令为:cd 文件夹路径

示例代码:cd /home/AI

3)检查文件

示例代码:ls

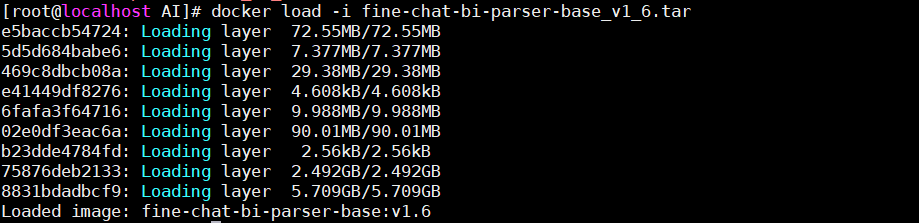

4)运行镜像文件,命令为:docker load -i 镜像文件压缩包

示例代码:docker load -i fine-chat-bi-parser-base_v1_6.tar

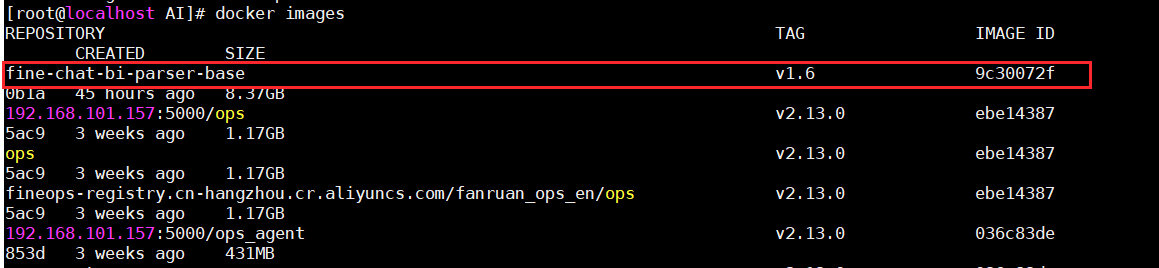

5)运行完成后,使用命令检查,出现镜像的名称和版本号即为完成,命令为:docker images

示例代码:docker images

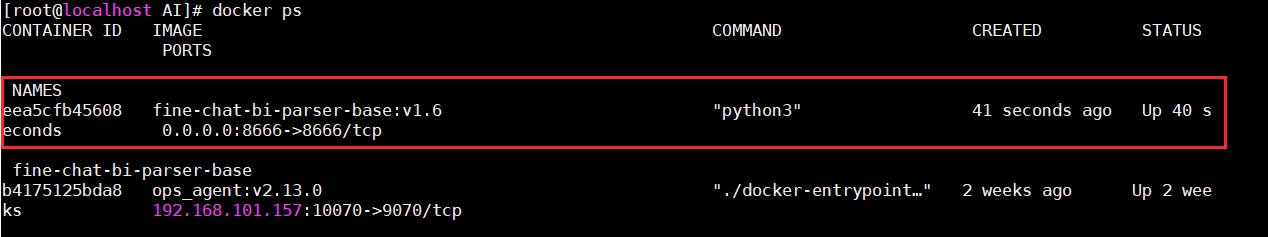

6)使用命令运行镜像,命令为:docker run -it -e TZ=Asia/Shanghai --name fine-chat-bi-parser-base -d -p 8666:8666 基础镜像名称:基础镜像版本号

示例代码:docker run -it -e TZ=Asia/Shanghai --name fine-chat-bi-parser-base -d -p 8666:8666 fine-chat-bi-parser-base:v1.6

![]()

7)使用命令检查容器,命令为:docker ps

3.3 安装代码

1)将获取的代码文件 encrypt_vXX_XXX.tar 包上传至服务器,之后再解压。命令为:tar -xvf 代码文件路径/代码文件名称

示例代码:tar -xvf /home/AI/encrypt_v1_5_1.tar

2)将代码文件放置到镜像中,命令为:docker cp 代码文件路径/代码文件名称 fine-chat-bi-parser-base:/root/

示例代码:docker cp /home/AI/encrypt_v1_5_1/ fine-chat-bi-parser-base:/root/

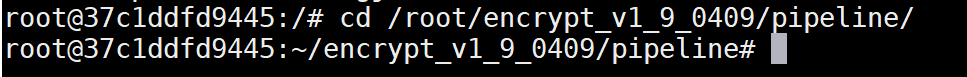

3)进入镜像的 /bin/bash 文件夹中,命令为:docker exec -it 镜像名称 /bin/bash

示例代码:docker exec -it fine-chat-bi-parser-base /bin/bash

4)进入代码文件夹,命令为:cd /root/代码文件名称/pipeline/

示例代码:cd /root/encrypt_v1_5_1/pipeline/

5)运行代码,命令为:nohup python app.py &

示例代码:nohuppython app.py &

ps:终端显示nohup: ignoring input and appending output to 'nohup.out'命为正常现象)

6)可直接关闭终端,退出 Docker 容器。

4. 部署 FineAI编辑

在为 FineAI 准备的服务器环境中执行本节操作。

4.1 安装 Docker

检查服务器是否已安装 Docker,以满足 FineAI 部署的先决条件,检查 Docker 命令:docker --version

若没有安装则会显示 command not found,如下图所示,此时则需要在服务器上安装 Docker,安装步骤可参考:Linux系统在线安装Docker

若已安装则会显示 Docker 的版本信息,如下图所示:

4.2 上传并运行 Docker 镜像文件

FineAI docker镜像文件下载:FineAI 镜像文件

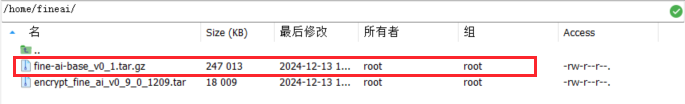

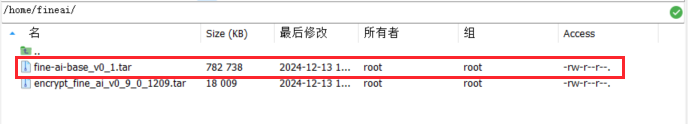

1)将 Docker 镜像文件(图中为 fine_ai.tar)传输至服务器的指定目录,示例路径:/home/fineai

如果收到后镜像文件以 .gz 结尾,则需要将其解压,解压后如下图所示:

命令示例:gunzip fine-ai-base_v0_1.tar.gz

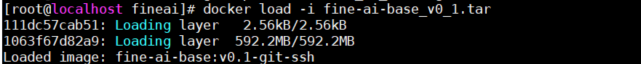

2)执行 docker load 命令以导入 Docker 镜像文件。

命令示例:docker load -i fine-ai-base_v0_1.tar

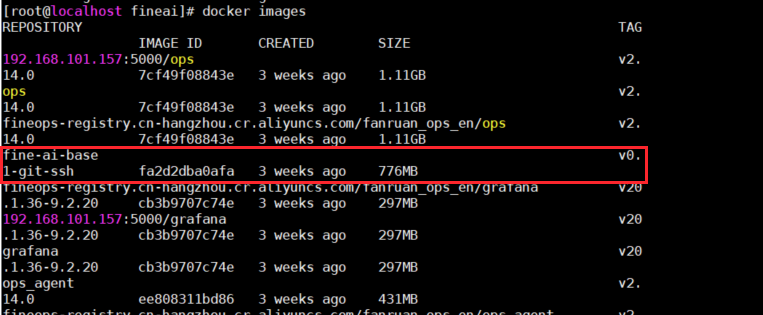

4)执行 docker images 命令以确认镜像是否已成功导入。

命令示例:docker images

5)依据已经导入的镜像,使用 docker run 命令创建并启动一个新的容器 。

命令示例:docker run -e TZ=Asia/Shanghai --name fine_ai -p 7666:7666 -it -d fine-ai-base:v0.1-git-ssh /bin/bash

![]()

4.3 安装代码

FineAI 代码文件:FineAI 代码

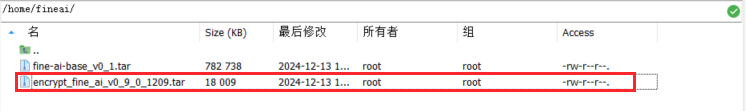

1)将代码文件 encrypt_fine_ai_xxxxx.tar 传输至服务器的指定目录,示例路径:/home/fineai

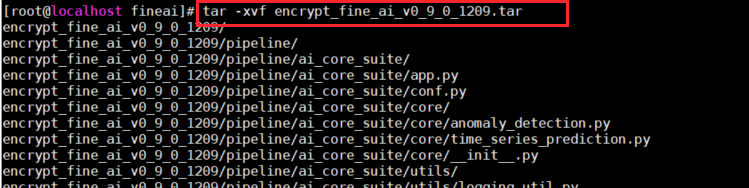

2)使用 tar -xvf 命令解压代码文件。

命令示例:tar -xvf encrypt_fine_ai_xxxxx.tar

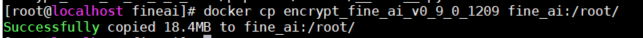

3)执行 docker cp 命令,将解压后的代码文件复制到容器路径 fine_ai:/root/ 中。

命令示例:docker cp encrypt_fine_ai_xxxxx fine_ai:/root/

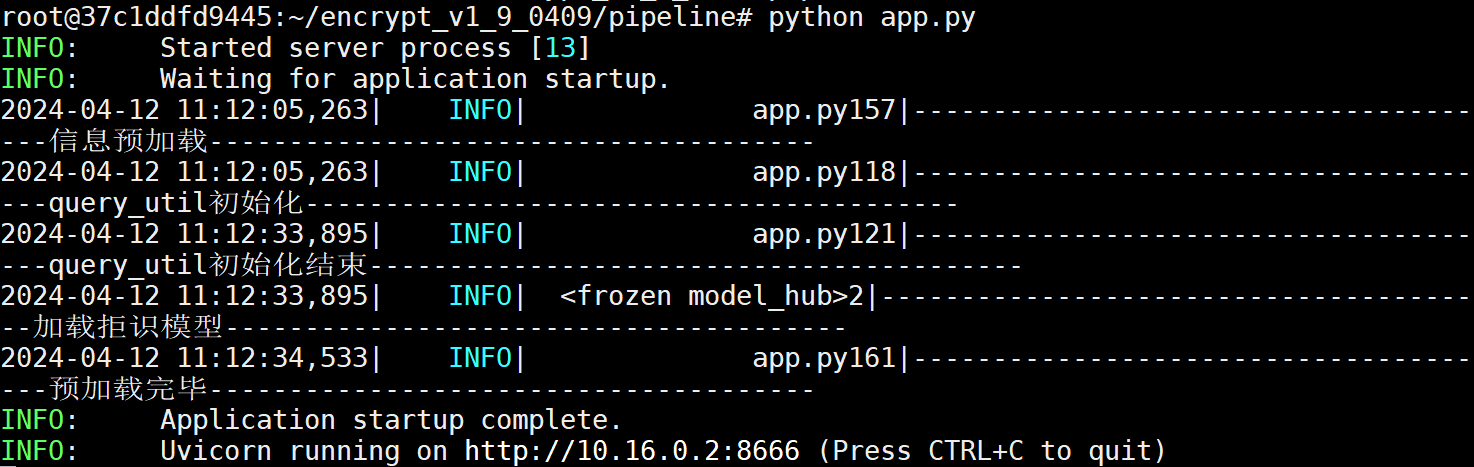

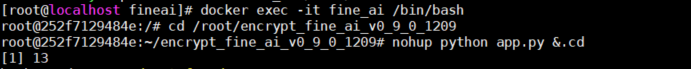

4)进入到容器中,并切换到容器内的代码路径中运行代码脚本。

进入容器 fine_ai:docker exec -it fine_ai /bin/bash

切换当前工作目录到代码路径中:cd /root/encrypt_fine_ai_xxx/pipeline

运行脚本:python app.py

5)依次按下 Ctrl+P 和 Ctrl+Q 退出 Docker 容器。

5. 安装 FineChatBI 插件编辑

1)下载 FineChatBI 插件:FineChatBI 插件

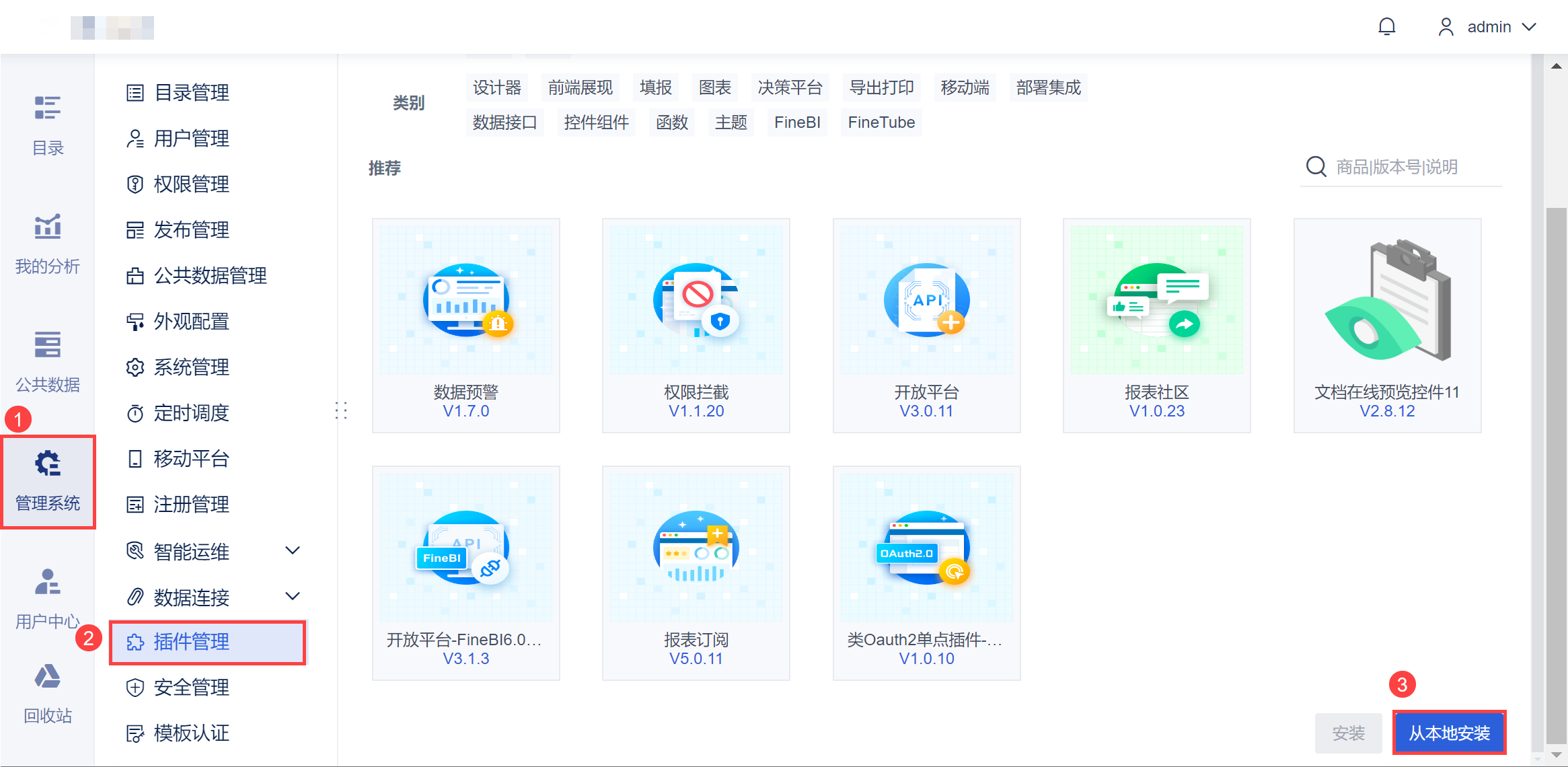

2)超管登录管理平台,选择「管理系统>插件管理>应用商城」,选择从本地安装获取的安装包,完成安装即可。

3)完成后刷新页面,选择「管理系统>智能问答配置>其他配置」,配置服务器 ip 和端口,点击保存即可。如下图所示:

| 填写项 | 描述 |

|---|---|

| 主机 | 语义解析小模型的 ip 地址 |

| 端口号 | 语义解析小模型的端口号(默认 8666) |

| FineAI服务主机 | FineAI 的 ip 地址 |

| FineAI端口 | FineAI 的端口号(默认 7666) |

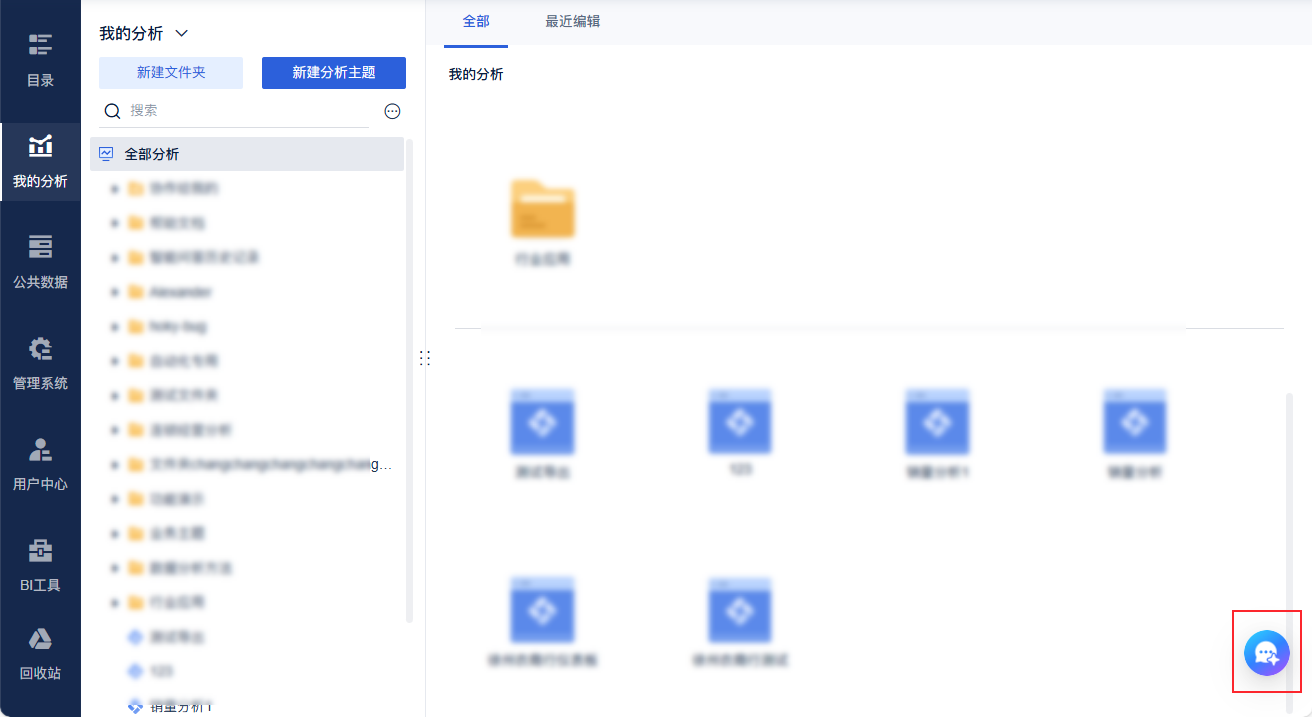

4)在管理系统右下角出现「问答BI」按钮即可完成,如下图所示:

6. 安装授权文件编辑

联系销售获取授权文件(fanruan.lic)。

7. 下一步:连接大模型编辑

进入 FineChatBI 服务架构概述 ,连接大模型。