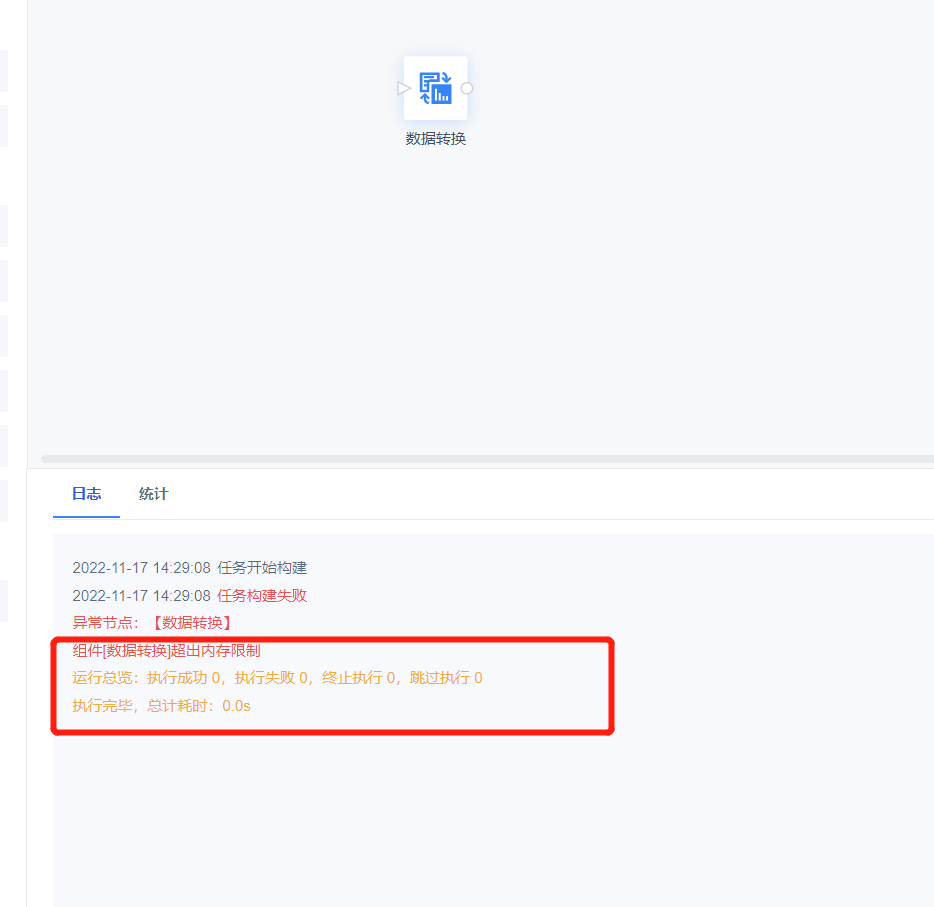

数据转换编辑

运行日志报错:超出内存限制

| 点击展开更多 |

问题描述: 任务运行失败,报错超出内存限制。

原因分析: 数据开发所占用的内存资源超过工程设置的上限。 解决方案: 可以根据实际运行任务情况,参考 机器要求 适当调整 Tomcat的JVM内存和任务运维的资源控制的数值 |

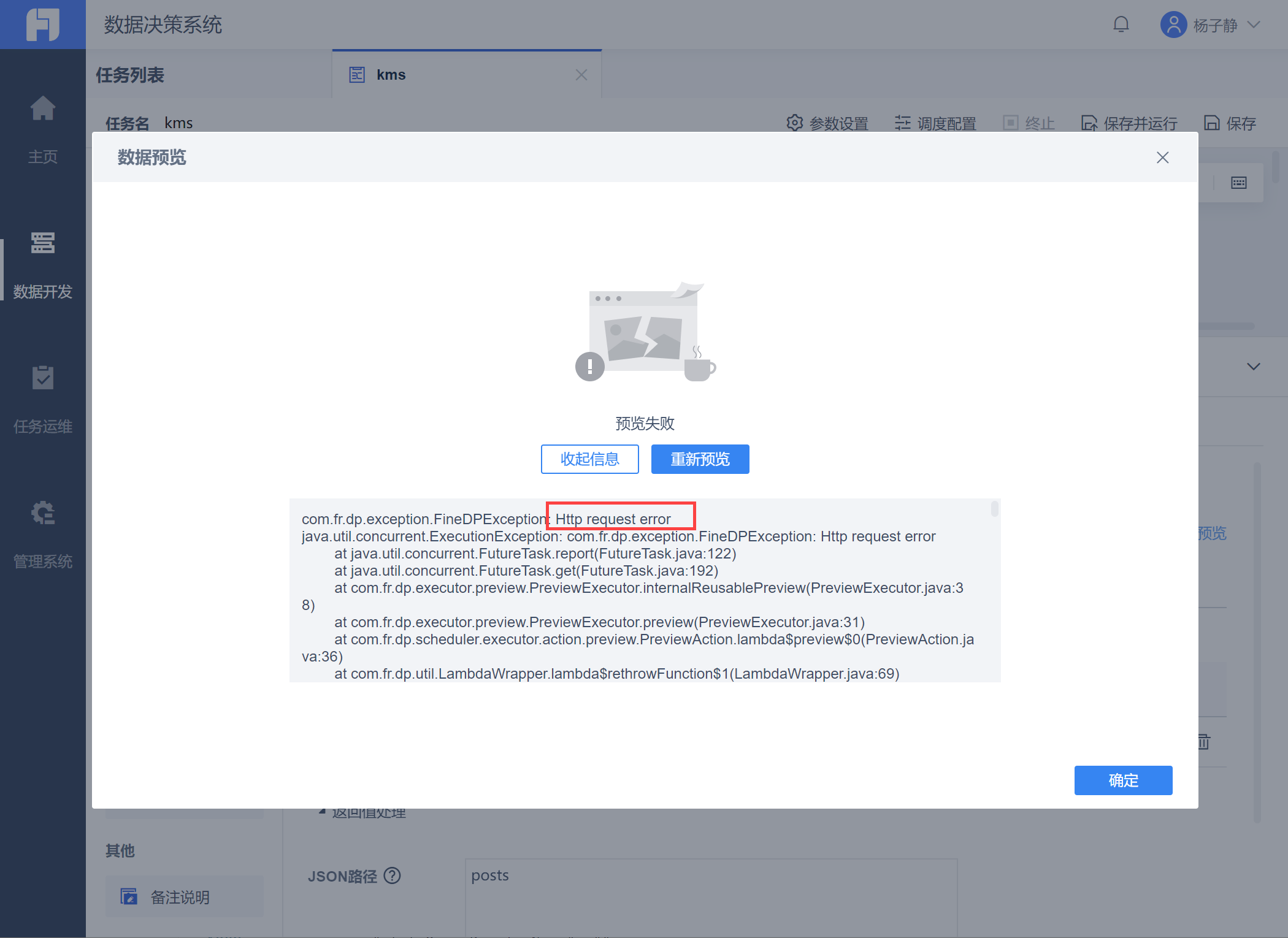

API 输入编辑

API取数数据预览报错:Http request error

| 点击展开更多 |

问题描述: 使用API取数,点击「数据预览」报错 Http request error,如下图所示:

原因分析: FineDataLink 默认超时是10s,耗时长的api会提示超时。 解决方案: 参考 FDLTimeout 在API Header 内使用 FDLTimeout 字段设置超时时间。 |

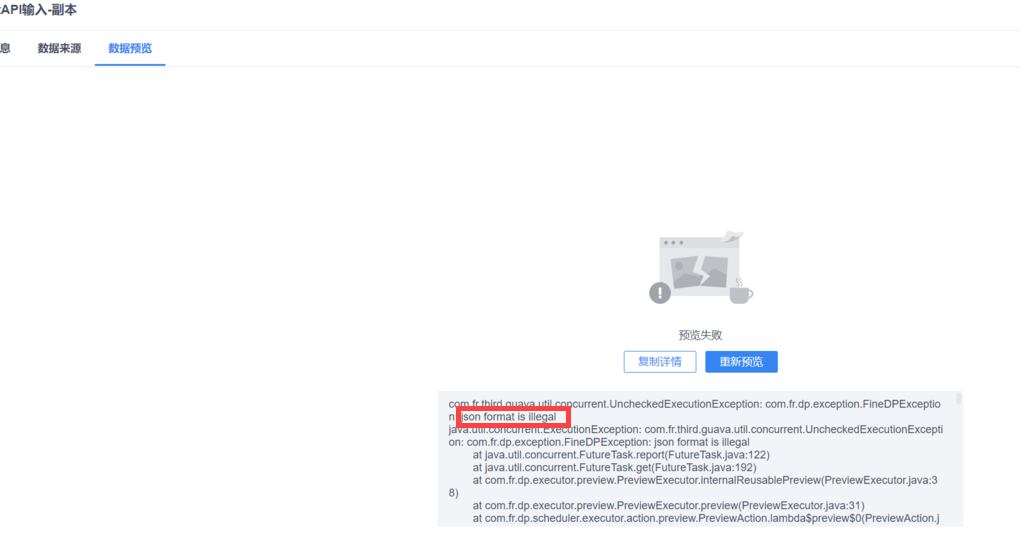

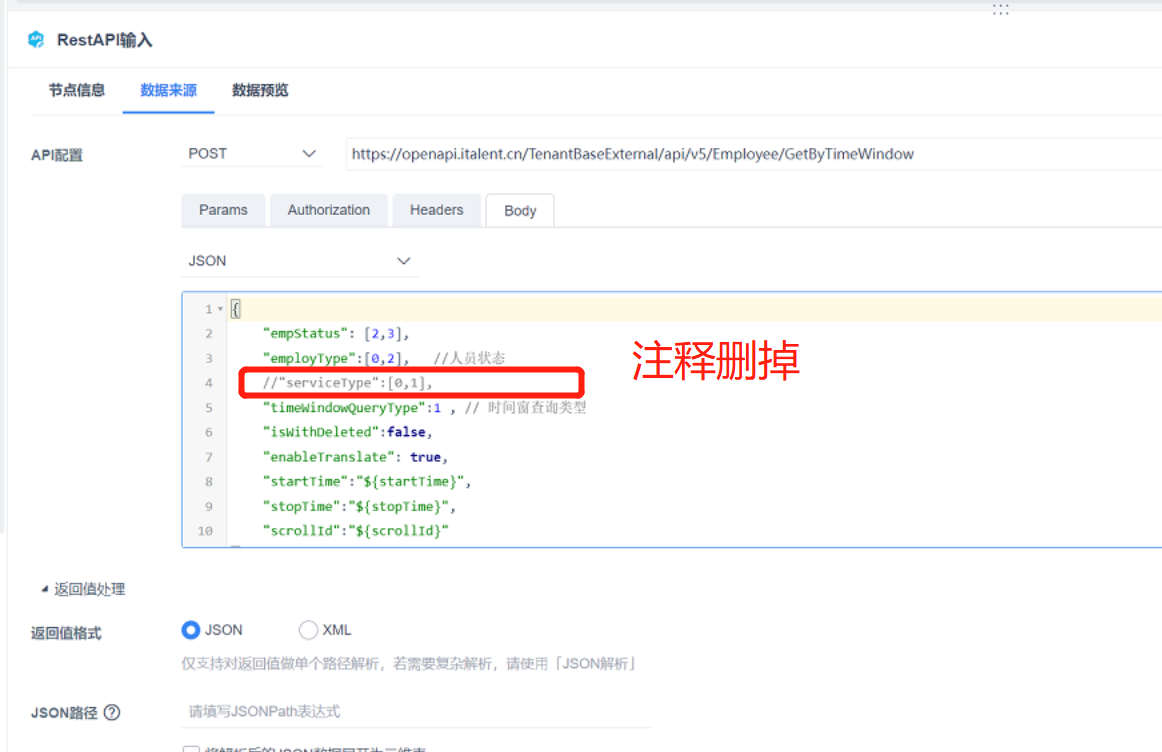

API 输入运行报错 json format is illegal

| 点击展开更多 |

问题描述: 使用API取数,点击「数据预览」报错 json format is illegal,如下图所示:

原因分析: 4.0.20 版本中加了json格式校验,API 的 body 请求中不再支持写入注释。 解决方案: 清除 body 中的注释即可。

|

数据关联编辑

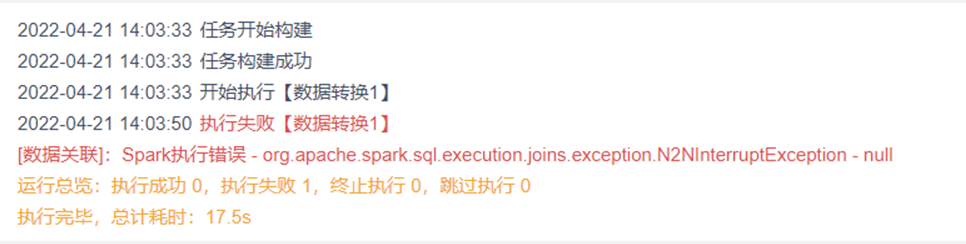

运行日志报错:Spark执行错误

| 点击展开更多 |

问题描述: 任务运行失败,报错提示[数据关联]: Spark执行错误- org apache spark sql. execution joins .exception.N2NInterruptException - null

原因分析: spark 保护机制,避免数据量极速膨胀触发服务器宕机,通常在关联结果膨胀超过5倍 + 关联数据量大于 1kw出现,属于正常现象。 满足下面所有条件,判定为不合理场景: 1)存在N:N的情况 2)N:N步骤的结果数据量超过1kw 3)N:N膨胀系数>=5 例如,100w 数据和 500w 数据N:N结果为2000w数据,那么N:N膨胀系数为: 2000w/500w =4,或者2000w/100w =20 |

DB表输出编辑

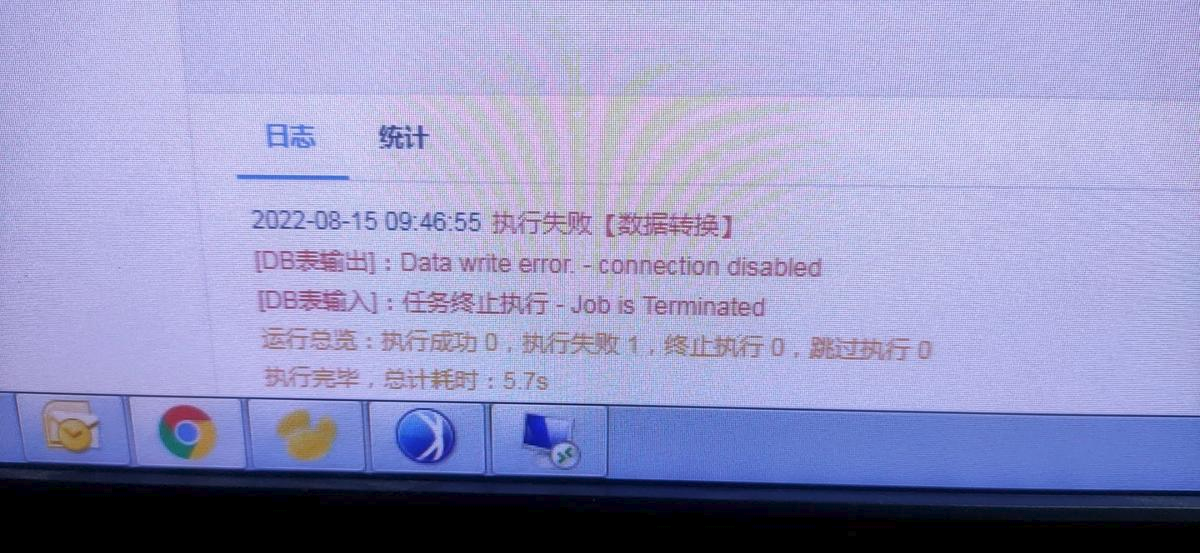

运行日志报错:Data write error - connection disables

| 点击展开更多 |

问题描述: 输出数据库为GreenPlum(并行装载)时,运行报错Data write error - connection disables

原因分析: gpdfist 文件不支持放置路径有空格 解决方案: 放置文件的路径下有空格,换个文件夹放置,并重启gpfdist进程,配置并行装载方案详情参见:配置Greenplum(并行装载)数据源 |