1. 概述编辑

1.1 应用场景

企业在在构建数仓和中间库时,由于业务数据量级较大,如果使用 数据同步 批量定时同步数据很难做到高性能的增量同步,若使用清空目标表再写入数据的方式时,还会面临目标表一段时间不可用、抽取耗时长等问题。

因此希望能在数据库数据量大或表结构规范的情况下,实现高性能的「实时数据同步」。

1.2 功能说明

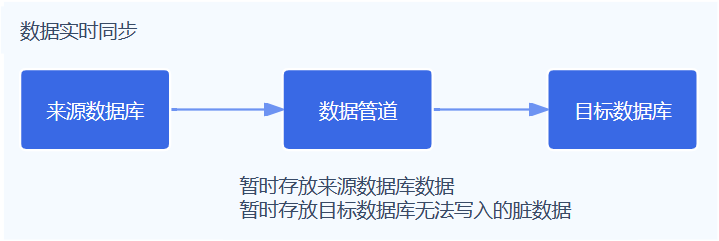

FineDataLink 监听数据管道来源端的数据库日志变化,利用 Kafka 作为数据同步中间件,暂存来源数据库的增量部分,进而实现向目标端实时写入数据。

支持对数据源进行单表、多表、整库数据的实时全量和增量同步,可以根据数据源适配情况,配置实时同步任务。

2. 约束限制编辑

3. 功能概述编辑

| 功能 | 描述 |

|---|---|

| 多种数据源间的数据同步 | 实时同步支持多种数据源,可以将多种来源端及目标端数据源搭配组成同步链路进行数据实时同步 数据管道支持的数据源请参见:数据管道支持的数据源类型 |

| 数据同步场景 | 1)支持对数据源进行单表、多表、整库数据的实时全量和增量同步:

2)同步类型为:

|

| 实时数据同步任务配置 | 实时同步任务配置无需编写代码,通过简单的任务配置即可实现单表、整库实时数据的同步 1)设置目标端:

关于实时同步各目标端支持的DDL操作详情请参见:同步源表结构变化

2)设置字段映射:

3)设置管道控制:

|

| 实时同步任务运维 | 支持对同步任务进行监控,详情请参见:管道任务运维

|

4. 操作流程编辑

注:配置管道任务完整示例请参见:管道任务示例

| 步骤 |

|---|

| 步骤一:数据源配置 根据实际情况选择源端和目标端数据库,数据管道支持的数据库请参见:数据管道支持的数据源类型 在数据连接管理中配置源端和目标端的数据连接,便于在管道任务配置过程中,通过选择数据源名称来控制同步任务的读取和写入数据库。详情请参见:配置数据连接 |

| 步骤二:准备数据库环境 基于需要设置数据管道任务的数据源,授予数据源配置的账号在数据库进行相应操作的权限。详情请参见:数据库环境准备概述 |

| 步骤三:管道任务环境准备 |

| 步骤四:分配管道任务权限 若需要使用数据管道的用户不是超级管理员,则需要为对应用户分配数据管道的使用权限。详情请参见:管道任务管理权限 |

步骤五:配置数据管道任务 详情请参见:配置数据管道任务 |

| 管道任务运维:单个管道任务管理、管道任务运维 |