1、概述编辑

1.1 应用场景

让不同的数据系统的数据能够快速、稳定地进行批量原表原样实时同步。

1.2 数据管道配置流程

1.3 数据管道任务页面

数据管道支持 多个数据源、多个目标库的 原样实时同步功能,如下图所示,支持创建管道任务、启动和暂停任务、查看任务详情以及删除该任务。

2、创建管道任务编辑

新建管道任务: 数据管道>管道任务>创建管道任务

2.1基本信息

在基本信息页面,主要分为三大部分:①任务名称、② 数据源、③ 目标库

数据连接信息,需要提前进行配置,若不存在,需要定义新的数据连接,请点击下拉框旁的添加按钮④和⑤,会跳转到 定义数据连接 页面。

2.2任务设置——数据源

①读取方式:数据管道任务目前仅支持基于日志的读取方式

MySQL: BINLOG 模式

Oracle: LogMiner模式

SQL Server: CDC 模式

② 读取起点(增量数据读取部分):

任务激活为起点:完成任务配置后开始进行同步。

自定义起点:点击后,可自由选择日期以及具体时分秒。

提示:读取起点为日志的读取起点,注意如果指定的解析时间在任务激活时间之前, 且在任务激活时间之前发生过对于所选择的数据源表的 DDL 操作,那么任务会报错并停止。

③ 存量读取:

开启:任务启动时,记录当前时间节点,将会先同步所有存量数据后,再通过日志模式从开始增量数据同步。

关闭:存量数据则从读取起点开始读取。

④ 读取并发数:在日志读取模式 (非批量读取模式)下,为存量同步时的并发线程数;批量读取模式下是每次读取数据时的并发线程数。

一般为默认为 5,最大建议不超过 FT 服务器最大 CPU 数量。

⑤ 读取速率:若为空,则不进行限制。

⑥ Kafka服务器地址:信息消息列队处理系统,点击测试连接,可确认是否连接成功。

⑦ Kafka高级设置:可默认,目前支持自由配置。

2.3任务设置——目标库

① 配置对应的目标库或者Schema。

② 写入并发数:设置任务最高能同时写入的表数量;写入速率限制:每秒最大行数 和 最大流量限制。

③ 表和名称字段:提供原表原样,以及规范大小写两种方式。

④ FDLoad设置:只有当目标库类型选择了FD之后,才会出现FDLoad配置,此处需要确保FD数据库和FT服务器通讯正常。

2.4预警信息

设置邮件通知,针对对错误队列设置,进行通知

2.5读取设置

选取数据源中的对应的表,可批量选取

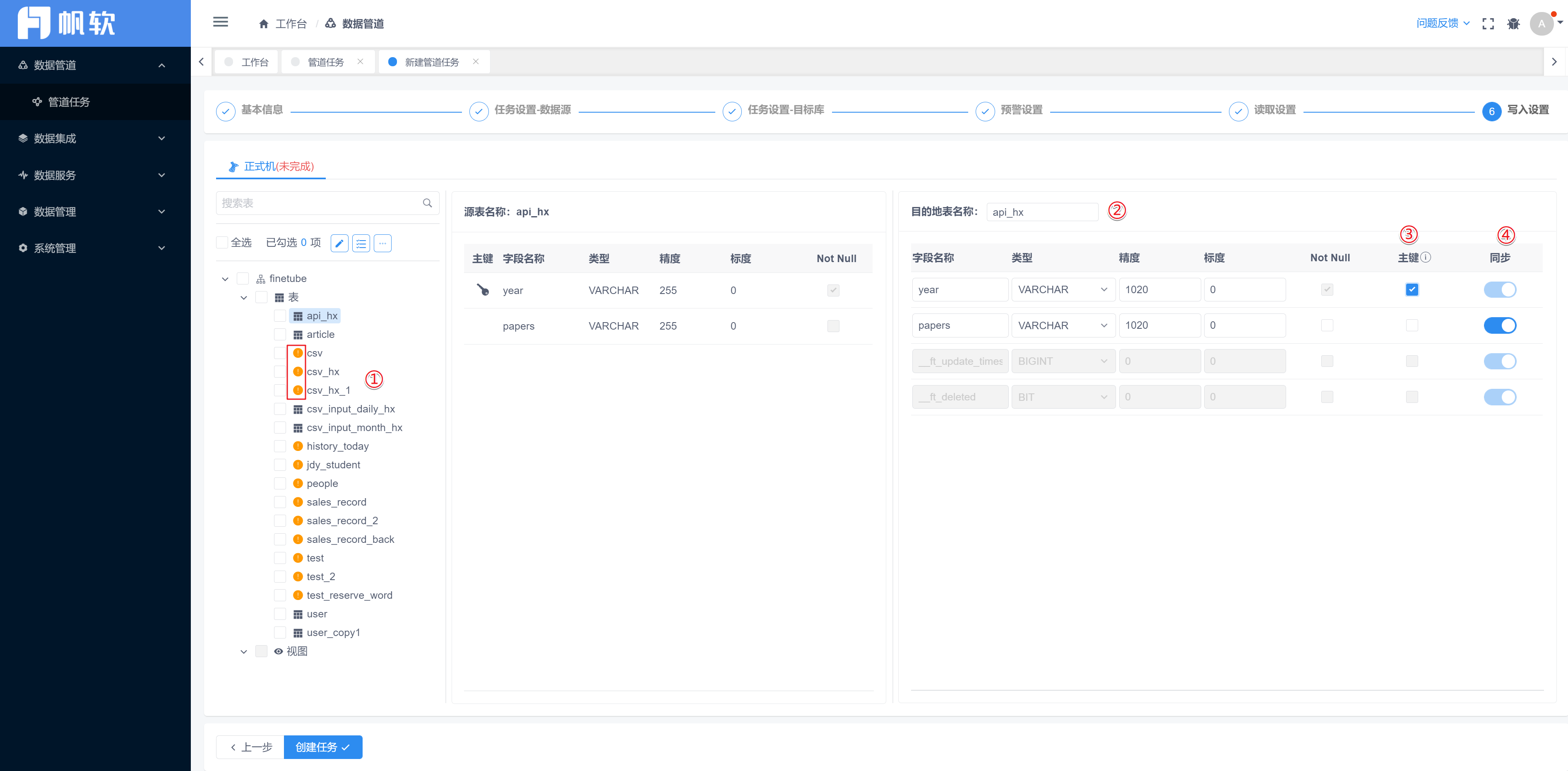

2.6写入设置

① 实时同步更新主要根据表的主键进行,若选取的表没有主键,则会出现如①所示的提醒。

② 目的地表名称,默认源表名称,支持自定义修改。

③ 主键一定是Not Null,勾选了主键后,则被设置为“一定同步”,如④所示。

④ 若存在无需同步,去掉勾选即可,此时目标表的此字段数据为空。

3、查看任务详情编辑

在 数据管道>管道任务 中,当鼠标悬浮在某一行的任务上时,可选择右侧的 查看任务详情,详情页看到任务设置、读取设置、写入设置 以及 错误队列、消息列表、运行监控。

其中:

错误队列:错误类型可以查看其具体原因的日志,以及相关原始数据。

消息列表:启动任务记录。

运行监控:分为检测数据同步差异监控 和 内存变量情况。