历史版本11 :FineChatBI 服务架构概述 返回文档

编辑时间:

内容长度:图片数:目录数:

修改原因:

1. 概述编辑

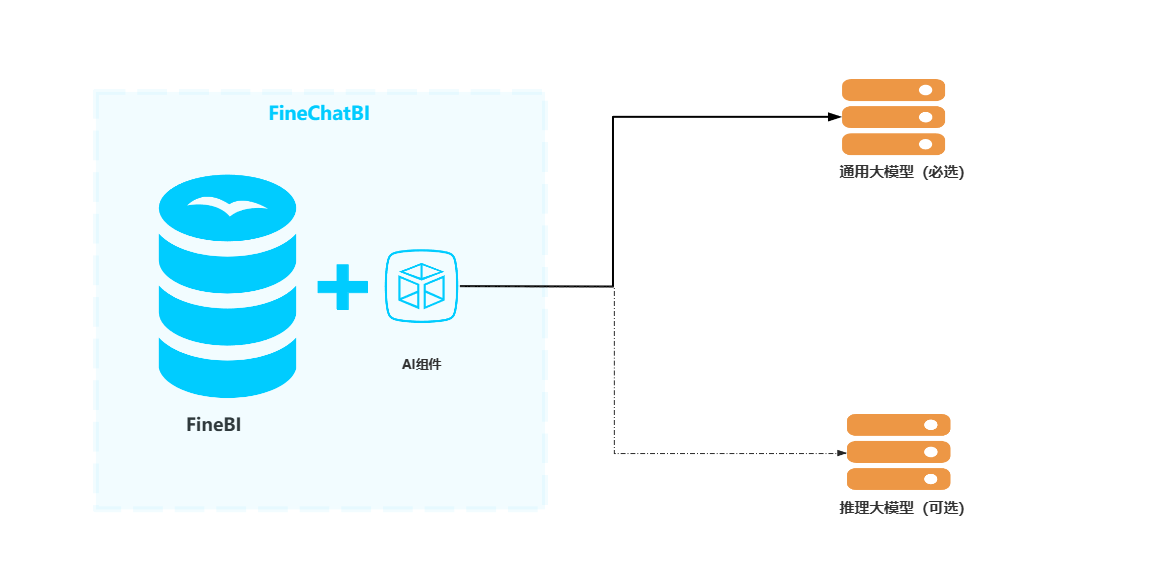

FineChatBI 整体服务架构可参考下图:

| 服务 | 描述 | 参考文档 |

|---|---|---|

| FineChatBI | 以 FineBI 为底座,叠加 AI 组件构建而成 | 运维平台为FineBI部署AI服务 |

| 通用大模型 | 通用大模型支撑以下功能:

| 通用大模型 |

| 推理大模型(可选) | 推理大模型支撑以下功能:

若资源有限,可使用通用模型,但效果会打折 | 推理大模型 |

2. FineChatBI 服务器配置概述编辑

2.1 FineBI 服务器配置

FineChatBI 以 FineBI 为底座,需要部署 FineBI V6.1 及以上版本。

参考 确认FineBI项目服务器配置 完成服务器选型。

计算规则:将 FineChatBI 的用户加入 FineBI 的日活用户数计算服务器所需资源,并额外预留 10% 的服务器资源用于 FineChatBI 的使用。

2.2 AI 组件服务器配置

由于AI组件所需资源较多,建议为AI组件单独准备一台服务器。

服务器要求如下:

推荐配置:CPU16核、可用内存32G、可用磁盘100G,AI组件独占服务器

最低配置:CPU12核、可用内存24G、可用磁盘50G,AI组件与项目共享服务器

详情请参见:准备AI组件服务器。