历史版本5 :FineDataLink與Kettle的差別 返回文檔

編輯時間:

內容長度:图片数:目录数:

修改原因:

| 分类 | FineDataLink | Kettle |

|---|---|---|

| 任务开发 | 学习成本低:流程化任务开发,快速上手,更低的学习门槛,具有 SQL 能力即可完成复杂数据处理 | 任务开发成本高:Kettle 产品功能设计风格接近传统代码开发工具,客户对于功能的理解成本高,同时任务开发成本也比较高 |

| FDL 作为一款 B/S 端工具,支持用户权限分离,支持多个用户同时登陆环境,分别进行各自部门的数据任务开发 | 无法协同进行任务开发:Kettle 是 C/S 端产品,并且不具有用户体系,无法实现多用户同时开发任务 | |

| FDL 数据管道支持毫秒级数据实时复制,支持企业业务系统数据库的快速备份、业务系统主从分离等操作 | 当业务数据库同时支撑业务系统的持续写入和数据批量抽取时,会造成业务数据库的性能下降,进而导致业务系统前端操作存在卡顿等性能问题 | |

| FDL 数据管道支持数据实时增量更新,可构建准实时数据仓库 | 传统数据仓库,以 T+1 进行数据更新,导致监控大屏等高时效性场景难以落地,传统数仓无法满足企业的监控分析诉求 | |

| FDL 数据管道支持业务系统的多表批量同步,相同数据抽取场景下,提高 30% 工作效率 | 构建数据仓库过程中,由于企业的业务系统、数据库表比较多,导致数据仓库的原始层构建需要创建成百上千个数据抽取任务 | |

打造企业数据中心,通过安全、稳定的方式将结果数据,以 API 接口的方式向企业内业务系统或其他数据消费方进行对外发布 基于 FDL 的 API 数据接入以及数据服务的能力,帮助客户构建了「联接共享」的数据基座,打通数据供应到共享的完整数据链路 | 缺乏安全的数据分享机制,随着数据消费端的数量增加,IT 部门会出现相同数据处理逻辑多次开发的重复造轮子情况 | |

| 通过 FDL 数据服务,让企业基于外网环境下也可以安全、稳定的进行跨地域数据传输,不仅为企业节省了专线成本,也便于企业自主监控并管理异常 | 当企业需要在多个分公司,也就是多地之间进行跨地域数据传输时,为保证数据安全以及传输稳定,会采用数据专线进行传输。但是专线动辄每年几十万、上百万,对于大多数企业来说都是比较大的负担 | |

| FDL 数据开发大幅降低数据从简道云上备份至本地数据库的开发和人工成本,同时支持将加工后数据回传至简道云内进行后续流程应用,实现云端数据管理合规诉求 |

| |

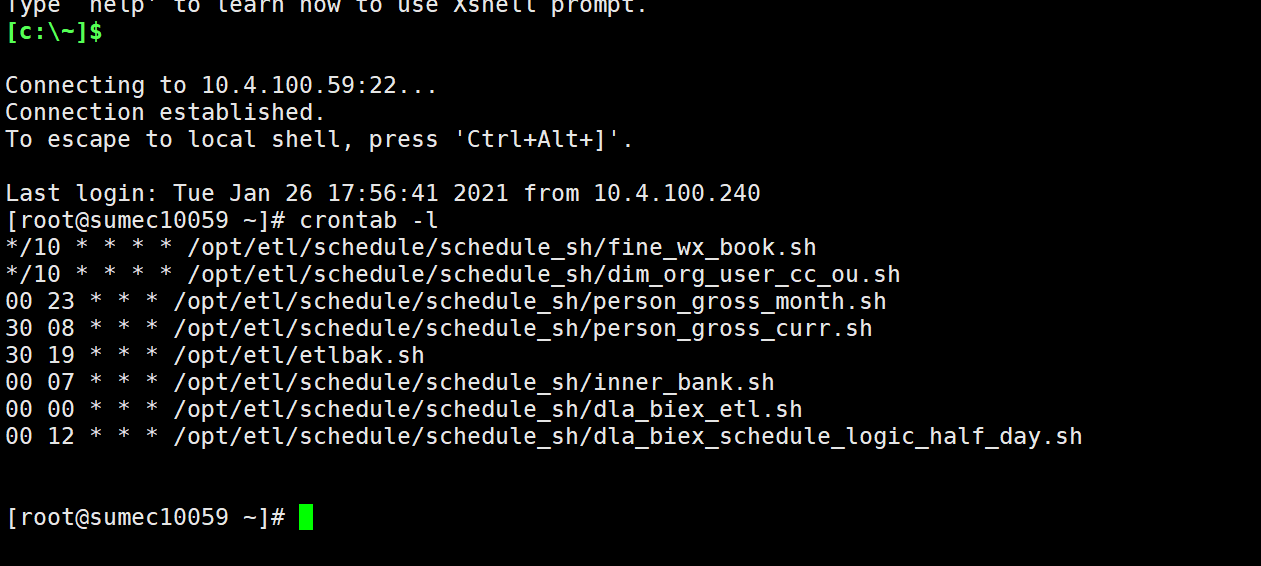

| 任务运维 | 开发和调度的便捷性:开发易用,针对业务功能封装节点、调度可视化配置,减少代码开发;更低的操作成本带来更高的开发效率 | 任务管理成本高、任务运行不稳定: Kettle 不支持调度管理,无法在工具内完成定时运行设置,需要借助 Windows/Linux 的定时器进行定时执行,Linux 系统中需要使用命令行进行操作,过程繁琐;同时由于系统定时器的不稳定,Kettle 任务容易出现执行失效问题

|

| 运维监控:运行日志即时展示、异常报错排查精准定位;运行状态实时监控,便捷的操作释放运维人员巨大的工作量 | 无法全局关注任务运行情况:Kettle 不支持对环境内全局任务进行总览,在任务运行报错后,客户不能快速查找到上次运行存在报错的任务,可能导致数据使用人员提出数据错误问题后,数据开发人员才后知后觉,影响数据决策分析效率 | |

| 多终端信息预警:调度配置、消息提醒功能,支持企业微信、钉钉、飞书以及短信、邮件等渠道,实现数据快速找人 | 任务运行报错不便捷:Kettle 任务存在执行报错时,仅可以通过短信、邮件等传统方式进行提醒,对于大部分客户来说,传统渠道并不便捷 | |

FDL 提供 负载分配 功能,用户在可视化界面中通过简单的拖拽,即可对定时任务、管道任务、数据服务进行独立的资源控制 | Kettle 的内存资源和并发控制方案通过配置文件和参数设置来进行调整,未提供产品化的内存资源调控机制 |