历史版本3 :Kafka输出 返回文档

编辑时间:

内容长度:图片数:目录数:

修改原因:

注:数据开发中实时任务当前属于内测阶段,如需试用或者了解详细信息,请联系技术支持(技术支持联系方式:前往「服务」,选择「在线支持」、电话「400-811-8890」)。

1. 概述编辑

1.1 版本

| FineDataLink 版本 | 功能变动 |

|---|---|

| 4.1.11.4 | - |

1.2 应用场景

用户需要实时读取数据,将数据处理后,将结构化数据序列化成 JSON 格式后放入至 Kafka 。

1.3 功能简介

FineDataLink 「实时任务」支持使用 Kafka 输出算子将数据实时同步输出至 Kafka 。

2. 功能说明编辑

| 配置项 | 说明 |

|---|---|

| 数据连接 | 配置Kafka数据源 后即可在此处选择 |

| 目标 Topic | 选择写入到 kafka 中的 topic

|

| 写入方式 |

只支持将数据插入到kafka |

3. 操作步骤编辑

用户将 MySQL 数据库中的结构化数据进行数据处理后实时同步至 kafka 中。

3.1 设置 CDC 输入

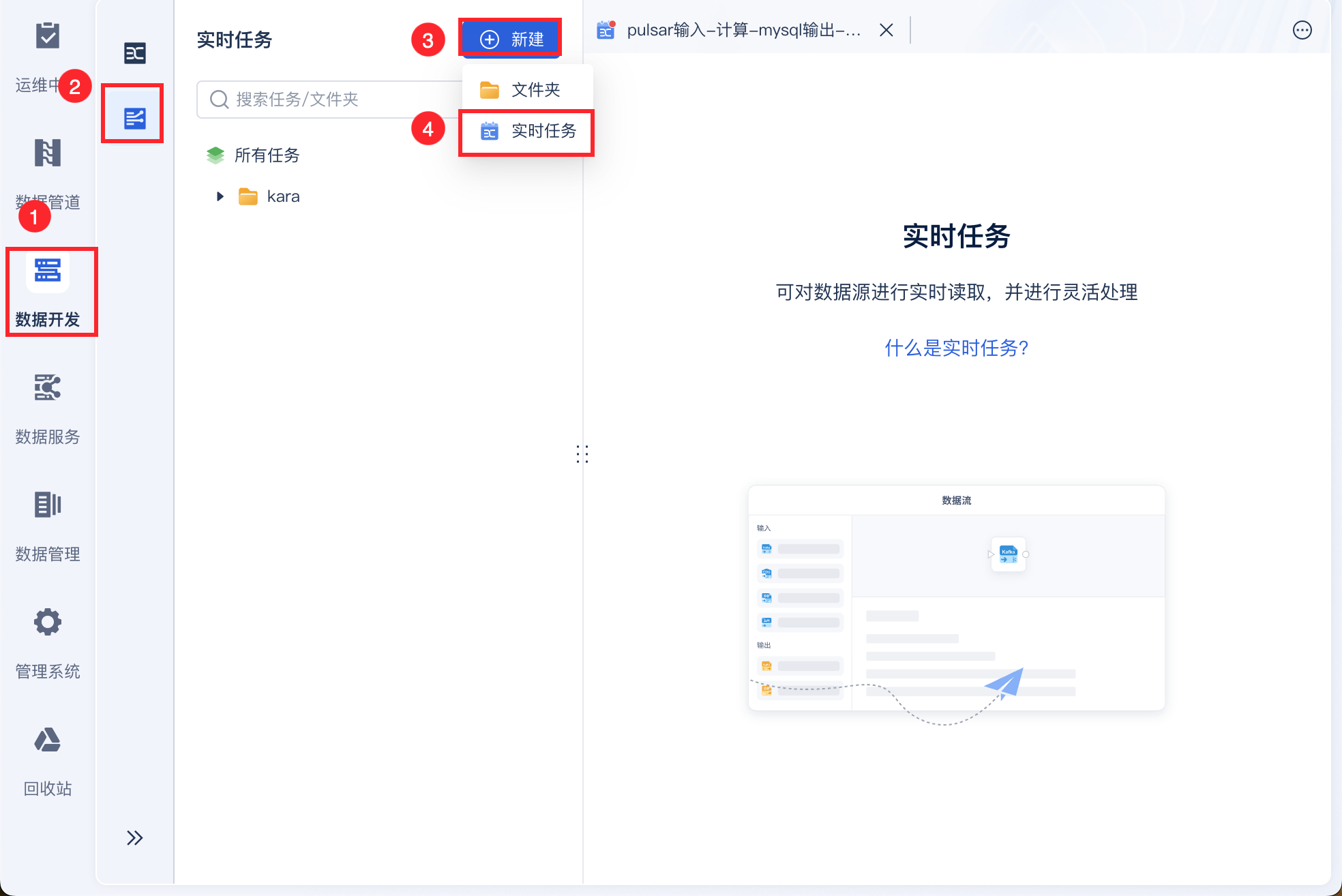

进入 FineDataLink 数据平台后,选择「数据开发>实时任务」,新建实时任务,,如下图所示:

注:需要注意的是如果使用 CDC输入,对应的来源端数据库需要开启日志,详情请参见:数据库环境准备概述

在任务管理界面选择「编辑」,如下图所示:

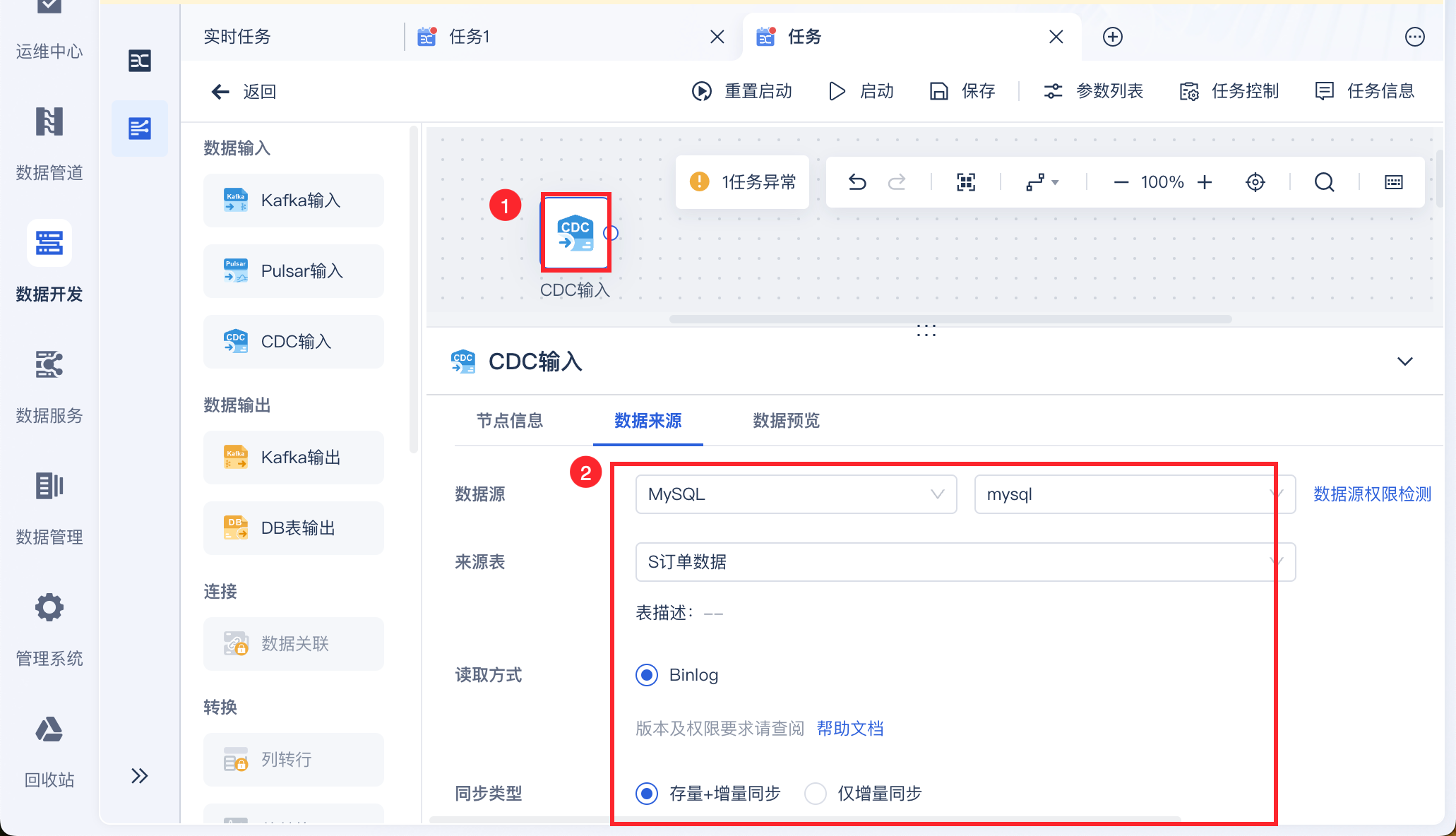

进入编辑界面后,拖入 CDC 输入算子,选择数据源并设置读取方式和同步类型,如下图所示:

注:选择数据源前需要先新建对应的数据连接,详情参见:创建并管理数据源

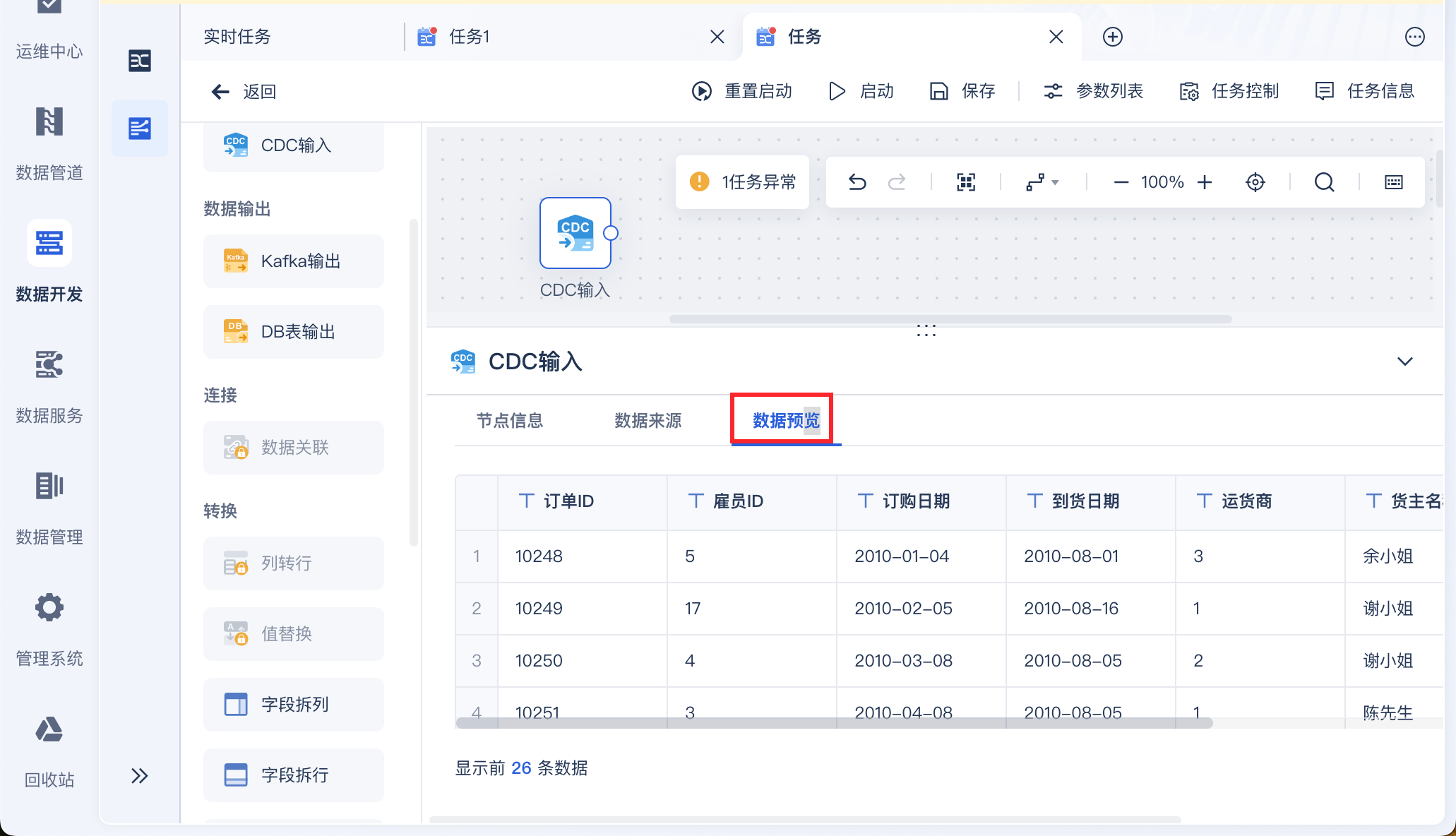

点击「数据预览」即可看到取出的数据库结构化数据,如下图所示:

3.2 数据处理

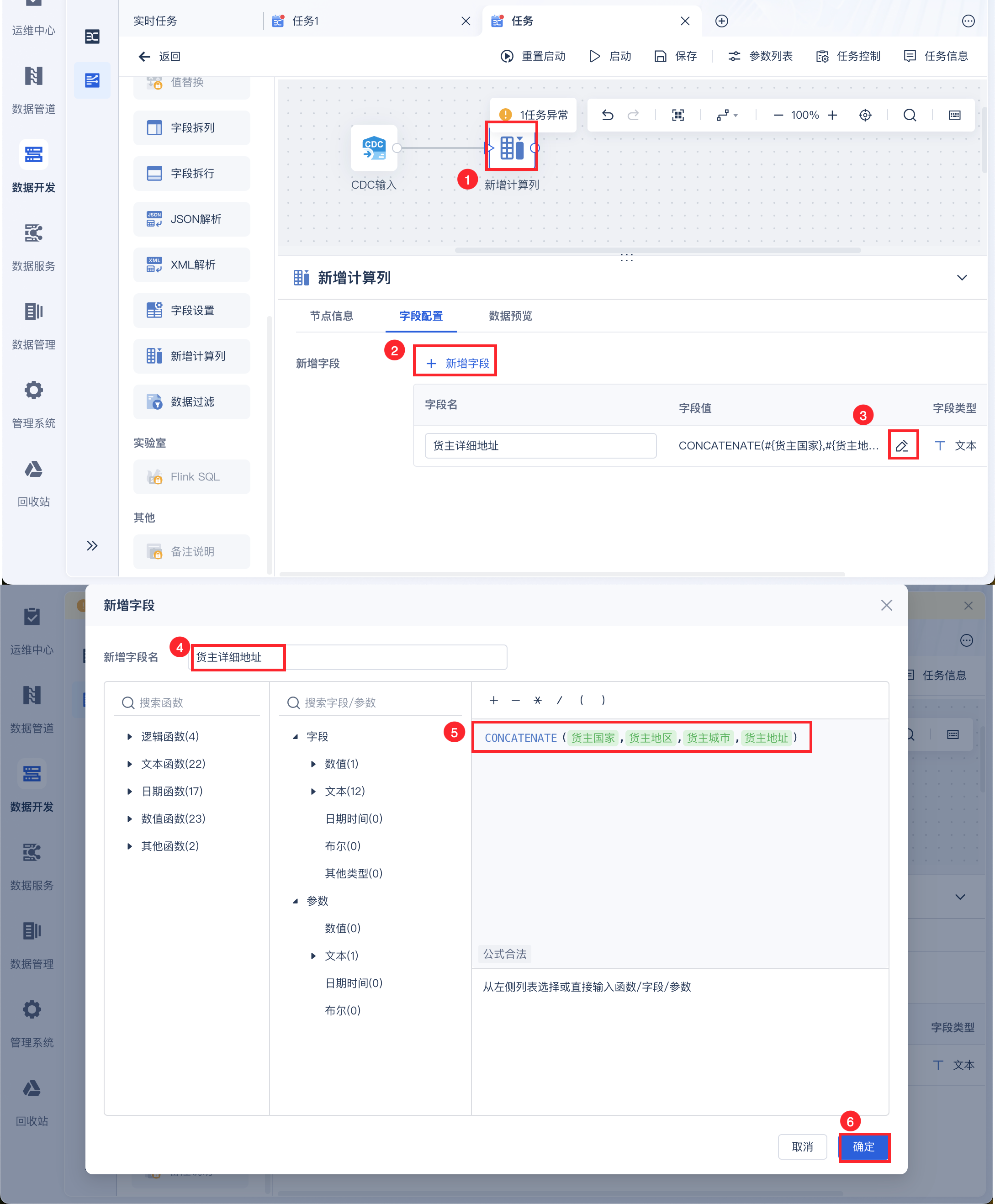

对读取的数据进行数据处理,例如新增计算列,新增一个字段拼接货主详细地址,如下图所示:

得到新增列如下图所示:

3.3 数据输出

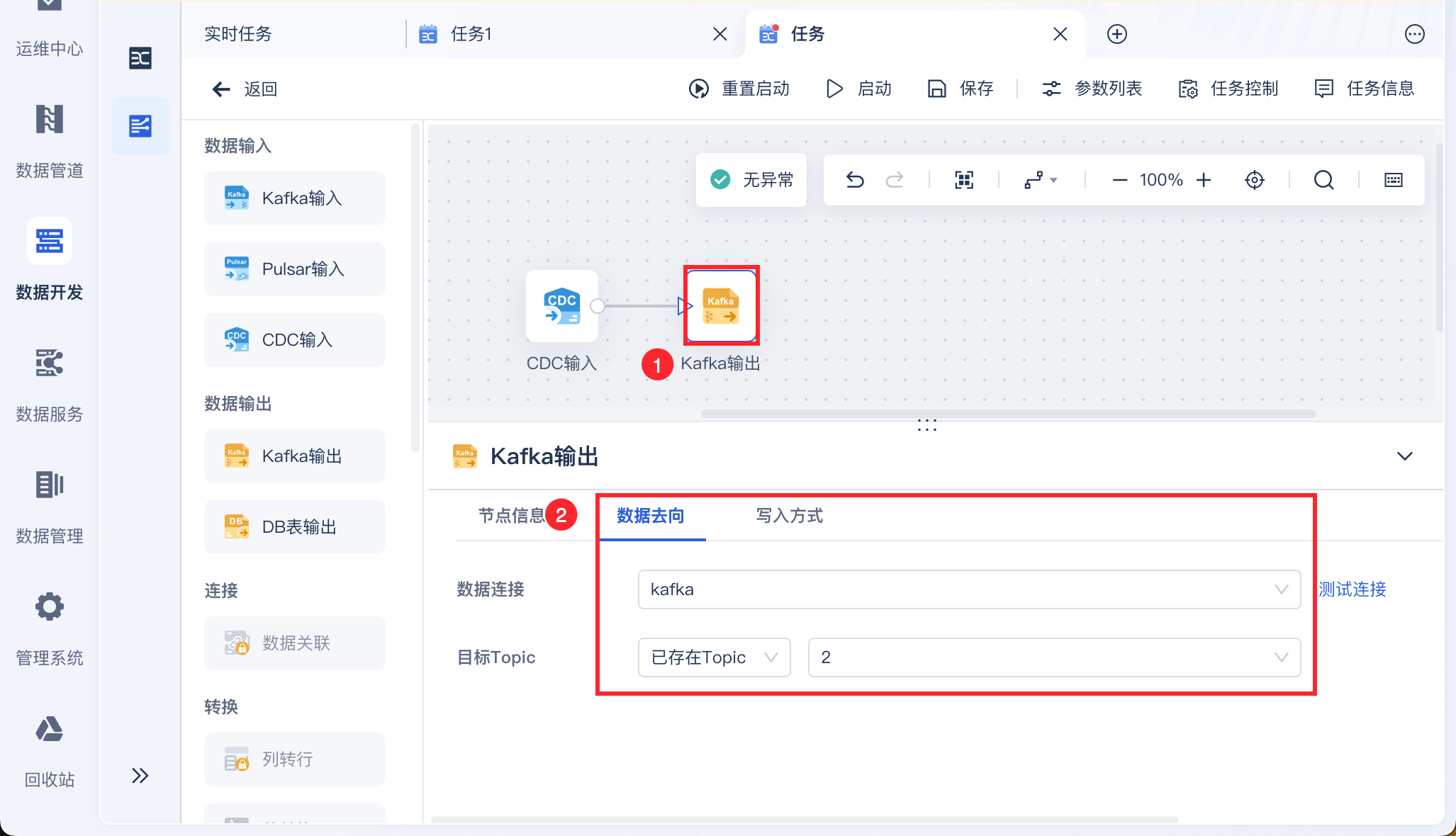

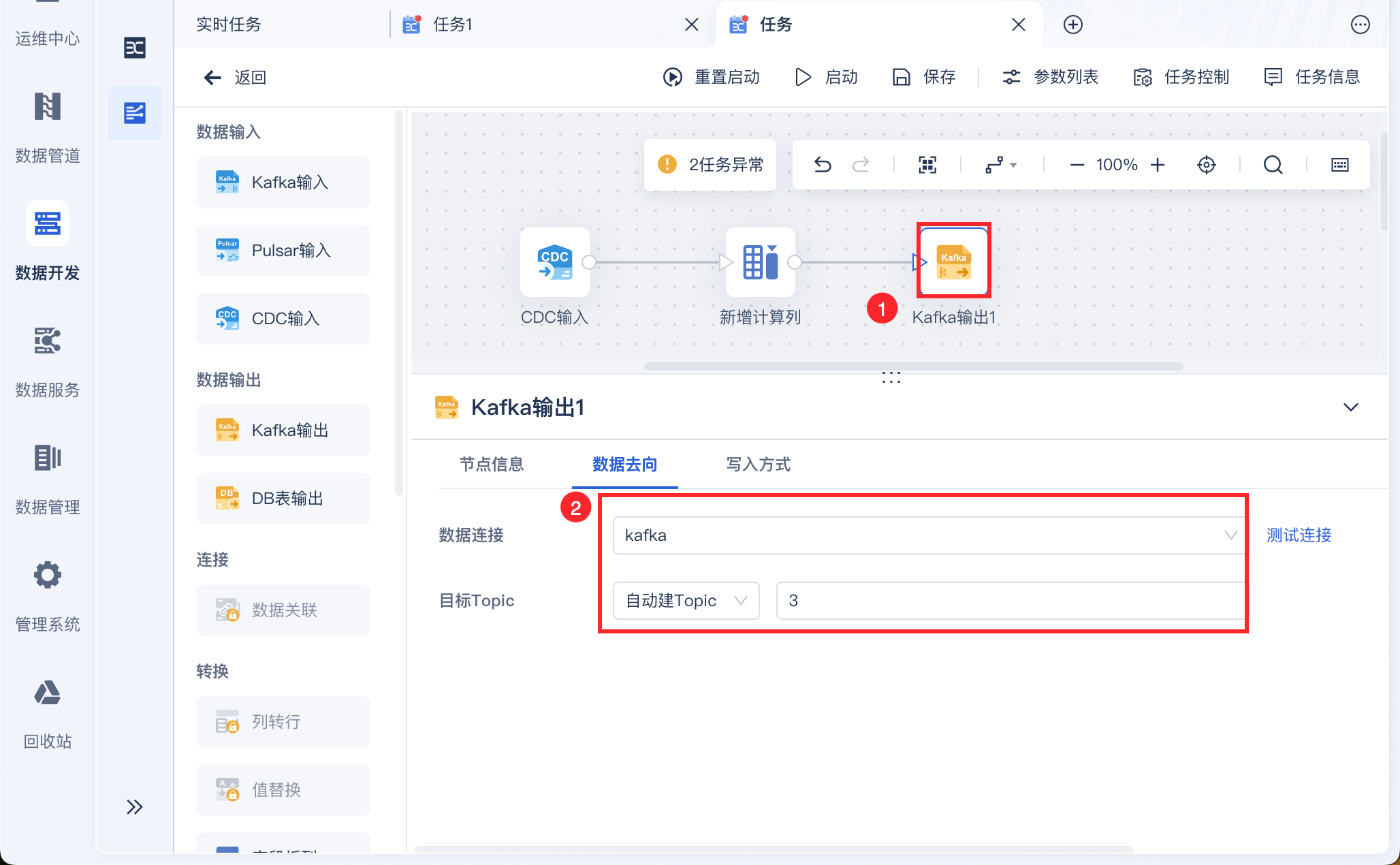

设置数据实时计算后输出至 Kafka 中,使用 Kafka 输出算子,如下图所示:

3.4 任务启动和管理

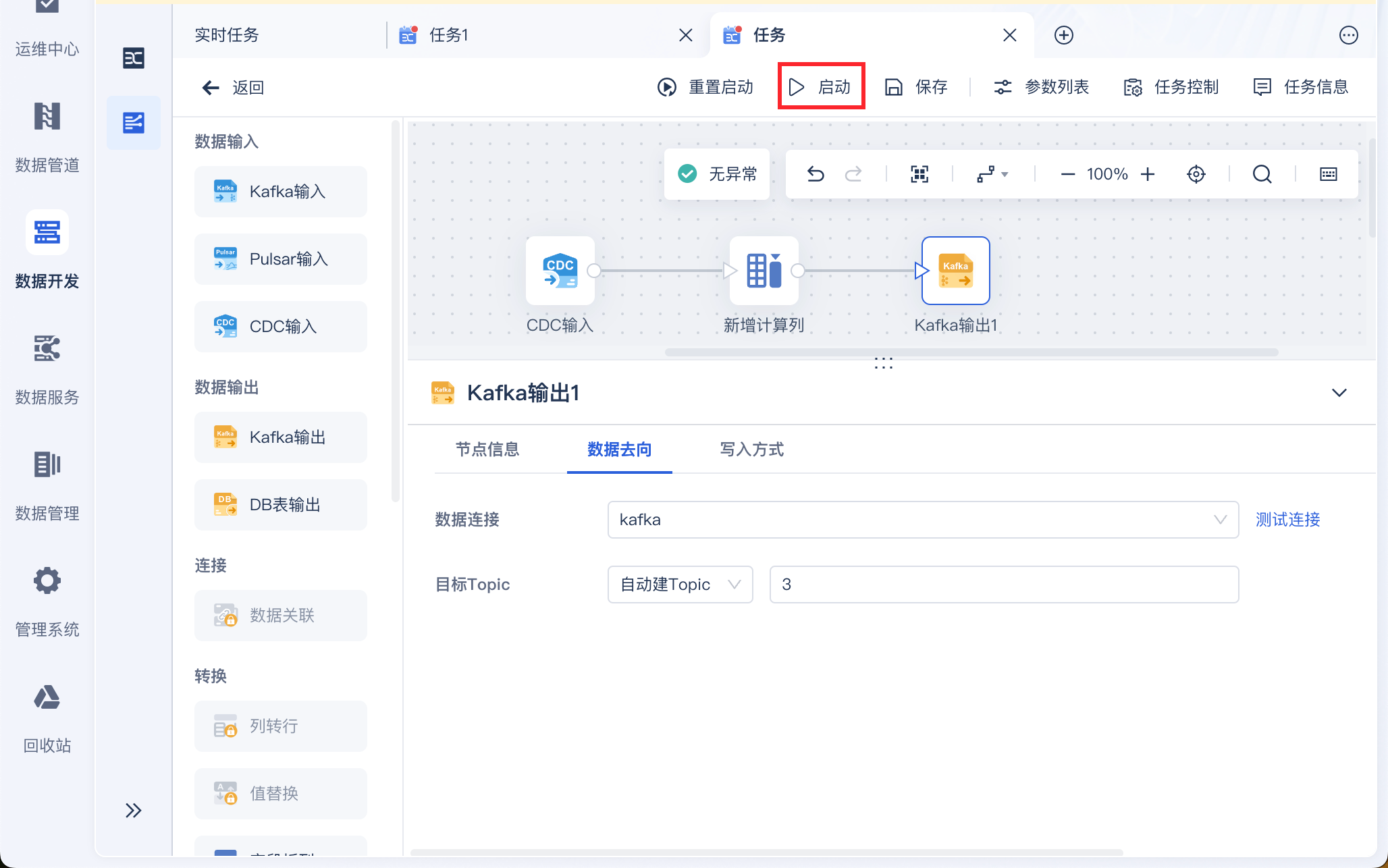

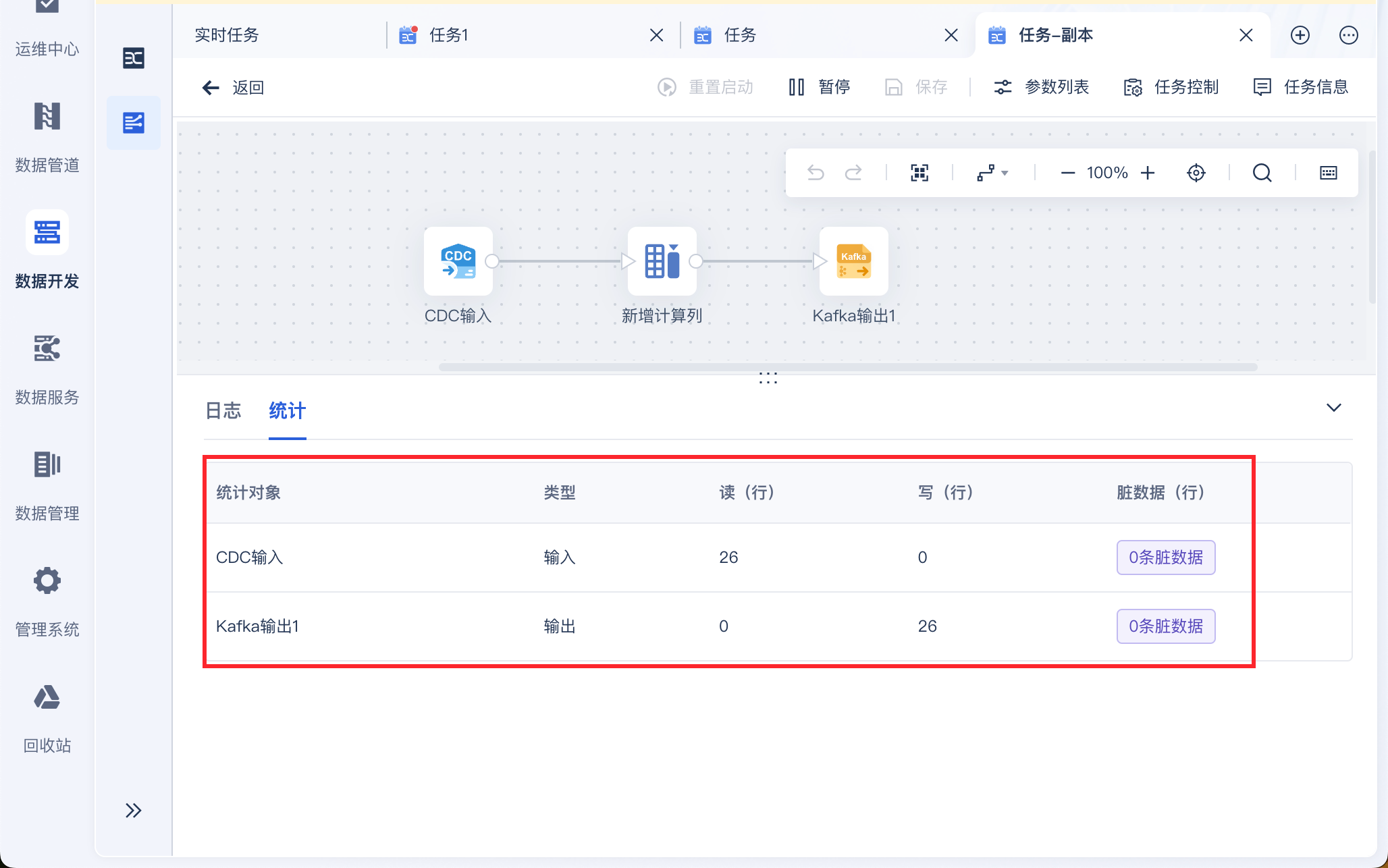

点击启动,即可启动实时任务,如下图所示:

3.5 效果查看

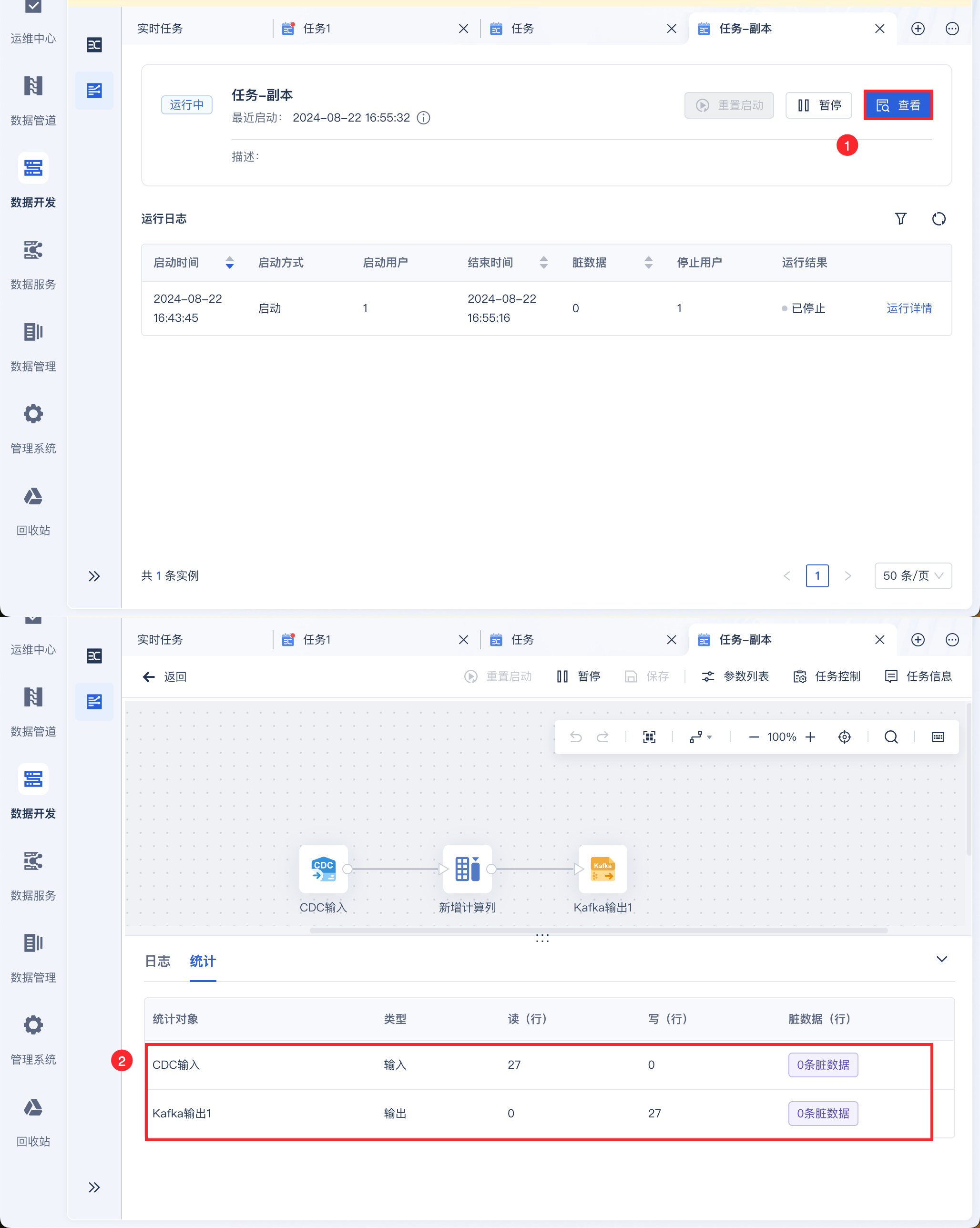

在日志中即可看到首次同步运行情况,如下图所示:

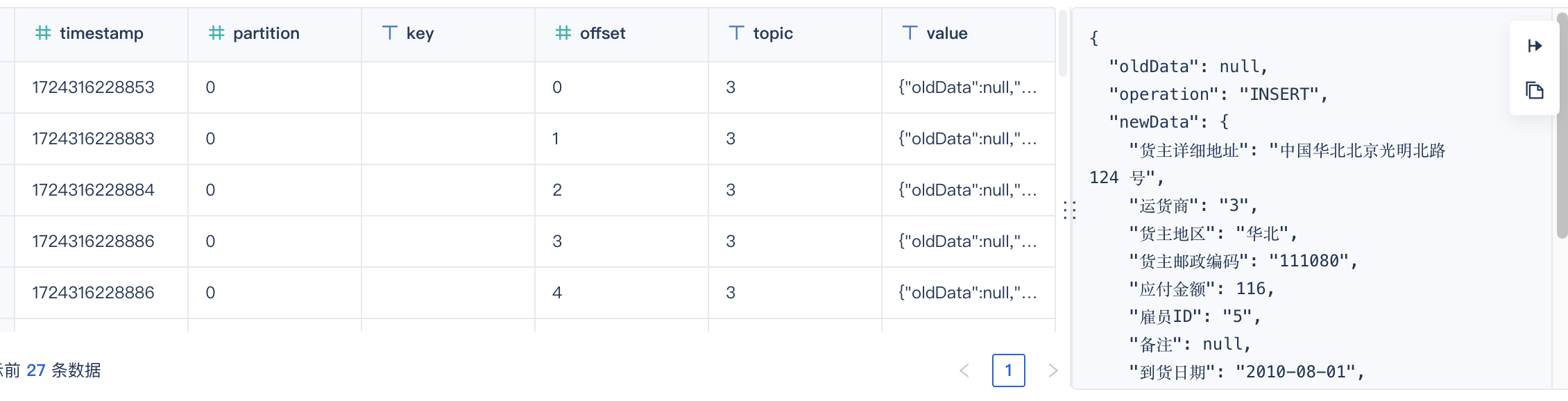

输出的 Kafka 数据如下图所示:

若此时来源端数据库中新增了一条数据,那么点击「查看」,即可看到实时任务的运行情况,同步了一条数据到 Kafka 中,如下图所示: