1. 描述编辑

Hadoop 是个很流行的分布式计算解决方案,Hive是建立在 Hadoop 上的数据仓库基础构架。它提供了一系列的工具,可以用来进行数据提取转化加载(ETL),这是一种可以存储、查询和分析存储在 Hadoop 中的大规模数据的机制。Hive 定义了简单的类 SQL 查询语言,称为 HQL,它允许熟悉 SQL 的用户查询数据。

下面介绍的是在平台中新建数据连接,若需要在设计器中新建,点击 [设计器]JDBC连接数据库 。

2. 数据连接编辑

2.1 配置信息

| 驱动 | URL | 驱动下载链接 | 支持数据库版本 |

|---|---|---|---|

| org.apache.hive.jdbc.HiveDriver | jdbc:hive2://hostname:port/databasename | hive_1.1; | |

| Hadoop_Hive_1.2;hive2.3; hive2.1.2;hive2.1.1 |

2.2 连接步骤

根据数据库的版本下载对应的 Hadoop Hive 驱动包,并将该驱动包放置到%FR_HOME%\webapps\webroot\webroot\WEB-INF\lib下,重启报表服务器。

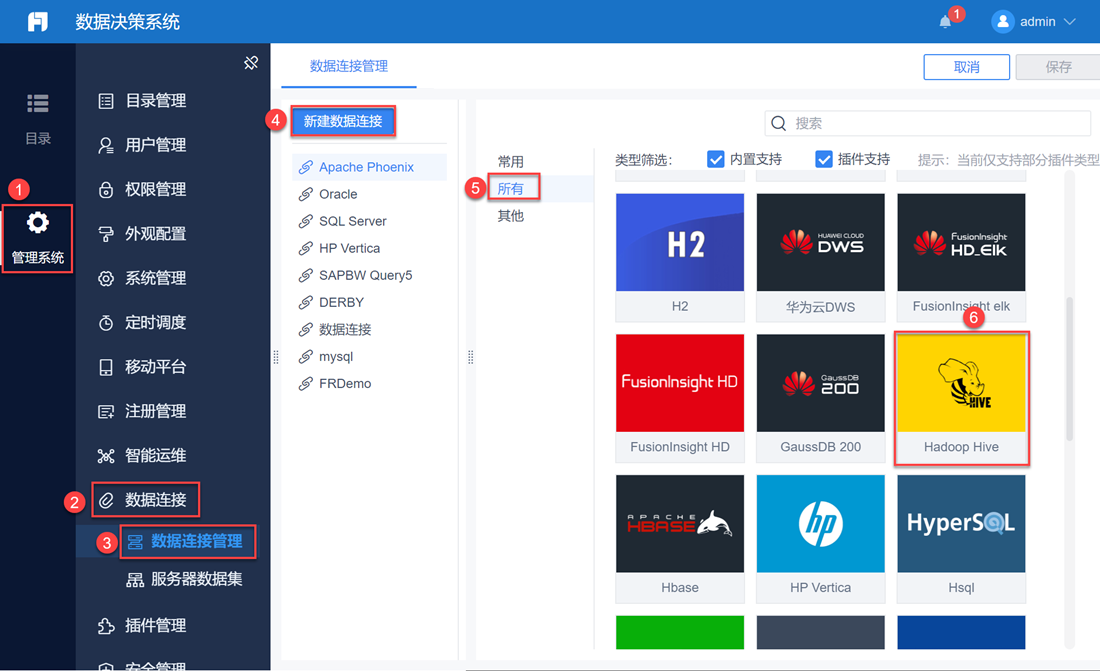

管理员登录数据决策系统,点击管理系统>数据连接>数据连接管理,点击新建数据连接,在所有选项下选择Hadoop Hive,点击确定,如下图所示:

注:如果非管理员用户想要配置数据连接,需要管理员给其分配管理系统下数据连接节点的权限,具体操作请查看 数据连接控制。

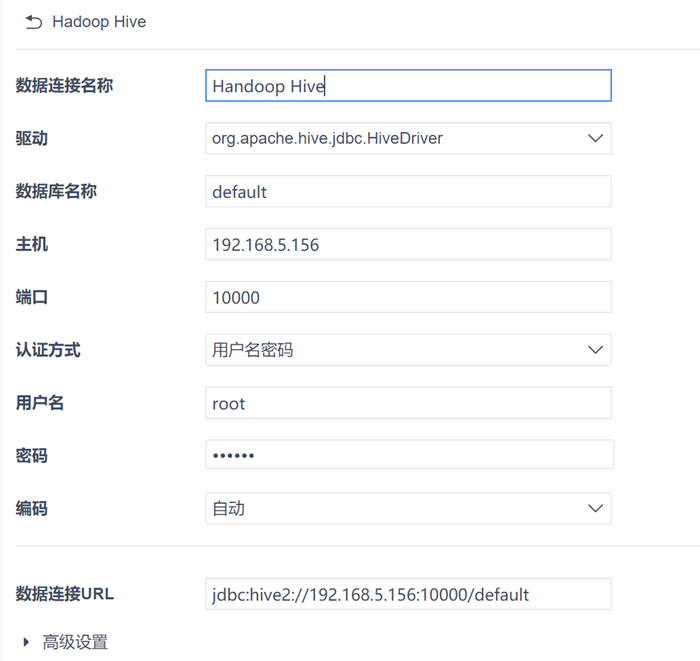

点击确定进入数据连接配置页面,按照前面提供的配置信息,输入自身数据库的对应信息。

a)可选择 kerberos 认证。若选择 kerberos 认证,则需填入注册过 kdc 的客户端名称、keytab 密钥路径和 kerberos 认证对应URL,参考 [平台]数据连接Kerberos认证 ,如下图所示:

注:连接前请检查 /etc/hosts 中的机器名对应 IP 是否为局域网 IP;/etc/hostname 中机器名设置和 /etc/hosts 中是否配置一致;FineReport 所在机器 hosts 配置的 IP+ 机器名是否正确。本地连接时需要配置 /etc/hosts 文件,添加远端映射:IP+机器名,例如: 192.168.5.206 centos-phoenix。

b)若不选择 kerberos 认证,则跟其他数据库设置一致,选择填入相关信息即可(相关介绍可参考 [平台]数据连接 ,如下图所示:

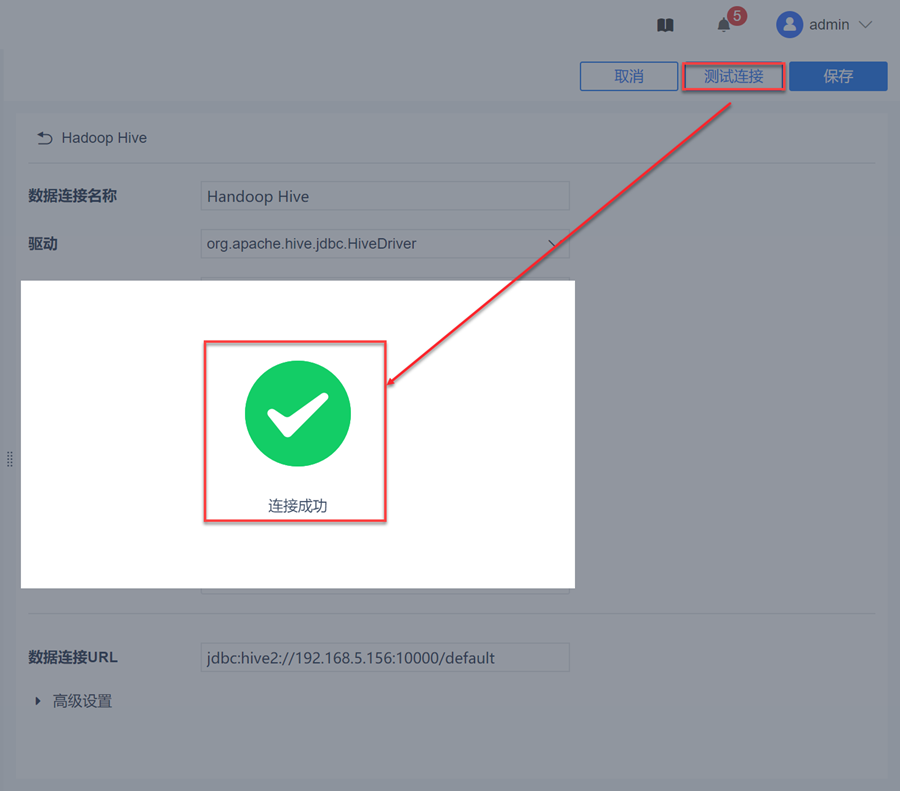

点击测试连接,若出现如下图的测试连接成功弹出框,则表示成功连接上数据库。如下图所示:

测试连接成功后点击右上角的保存按钮,该数据连接即添加成功。如下图所示: