目錄:

产品新功能编辑

数据开发

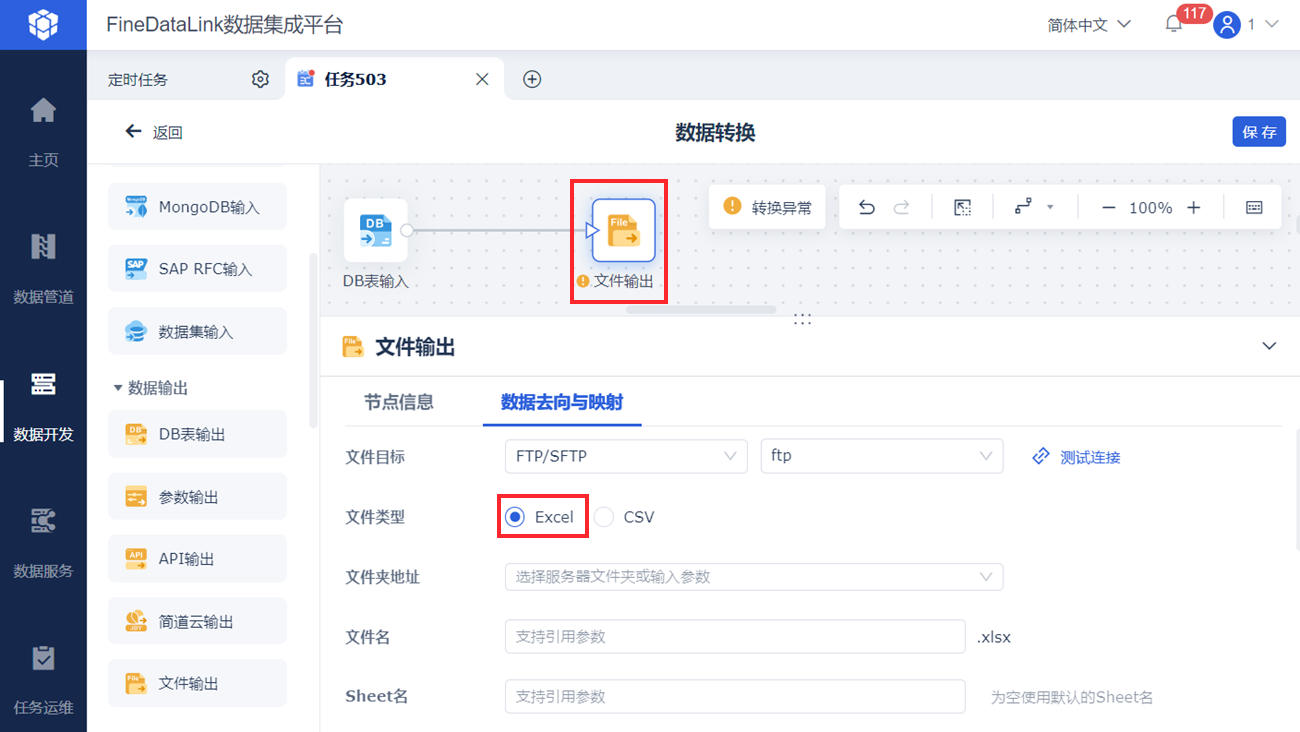

数据支持输出为 Excel 形式

支持将数据输出到本地工程或 FTP/SFTP 服务器中,且输出为 Excel 形式。

如下图所示:

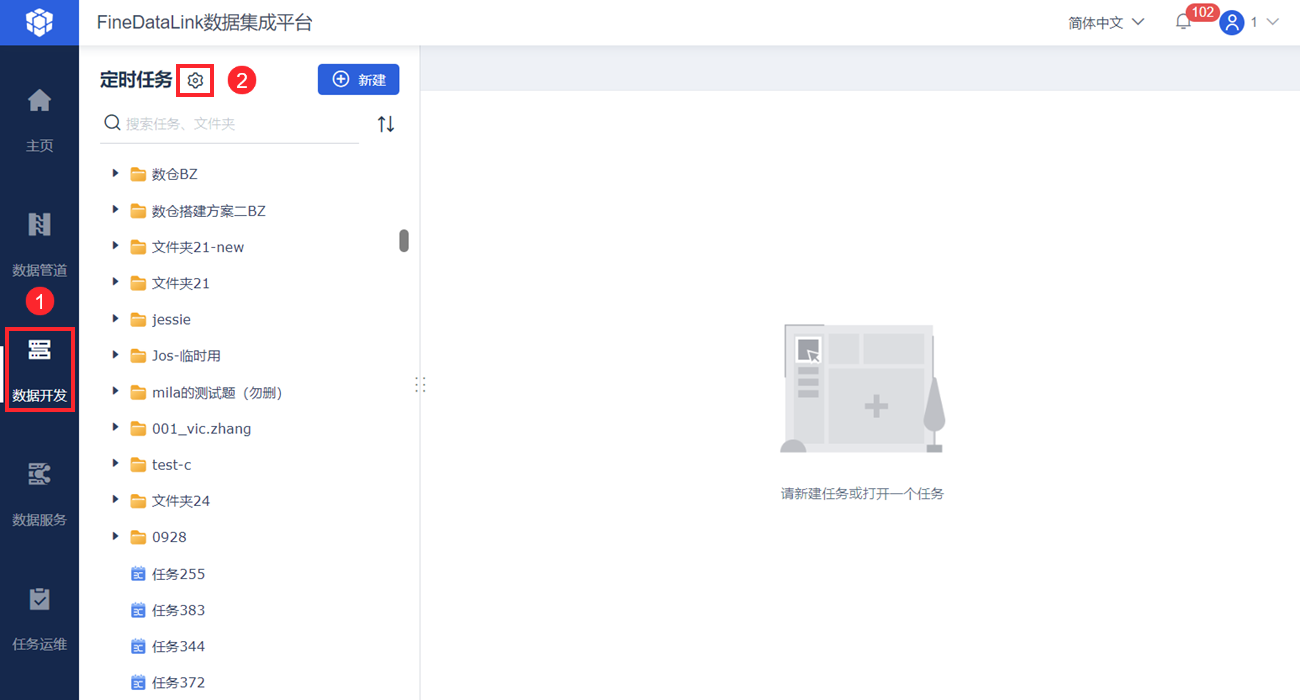

定时任务中支持设置全局参数

当多个定时任务需要使用相同的参数时,如果参数需要修改,每个定时任务都需要进行修改,实现过程比较麻烦。支持设置全局参数,该参数可在多个定时任务中使用。如下图所示:

详情请参见:全局参数

支持设置定时任务的调度依赖和优先级

1)支持为定时任务设置事件调度。

例如:数仓构建过程中 ODS 层有 a、b、c 任务互不影响、DW 层有 d 、f 任务,需要 a、b 任务执行完触发 d 任务,来减少 DW 层对 ODS 层完全更新完等待的时间;若 a、b 执行失败则不触发,来避免数据准确性的问题。

详情请参见:定时任务调度配置 2.2 节内容。

2)支持设置定时任务的执行优先级。当线程数不足时,优先执行队列中级别高的流,相同优先级的任务按照先进先出的顺序执行。

详情请参见:定时任务调度配置 第五章内容。

支持可视化展示定时任务的调用关系/依赖关系

可视化展示父子任务层级调用关系,用户可查看该定时任务被哪些任务调用,以及该任务调用了哪些任务。

可视化展示任务间调度依赖关系,辅助事件调度决策。

详情请参见:任务间调用/依赖关系展示

新增和优化注册方式

1)新增「容量」、「用户」、「节点」三个维度的注册限制。

当前的注册产品注册维度分为:「容量」、「时间」、「用户」、「功能点」、「节点」五个,控制维度最终结果取交集,用户可选择适合自己的注册维度。

详情参见:注册简介

2)FineDataLink license可以单独控制数据开发、数据服务、数据管道三个模块的到期时间。

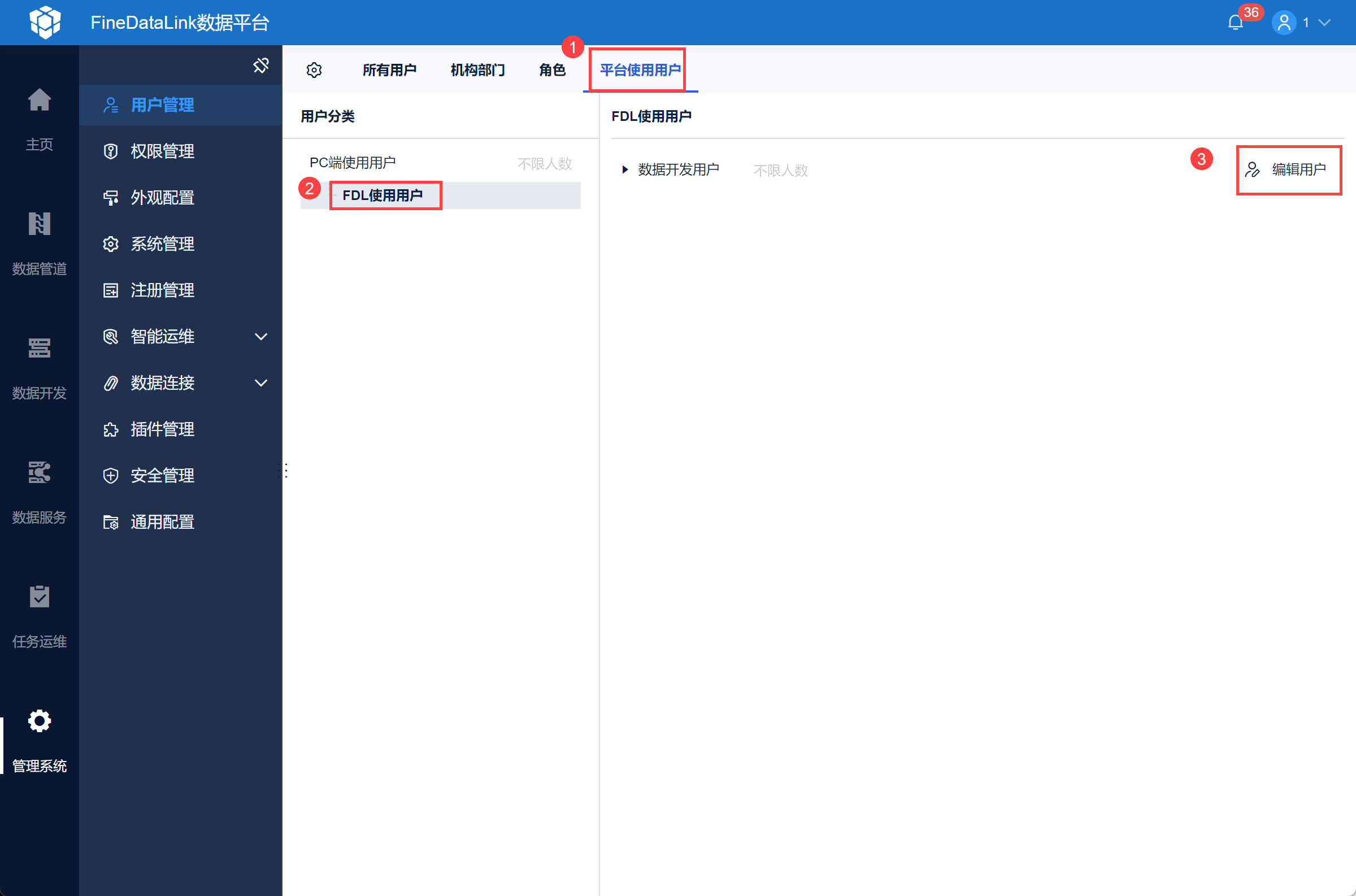

3)同时新增数据开发用户类型,便于从用户维度进行 FineDataLink 的注册管理。

详情参见:用户管理 第五章

4)对于注册功能点,也进行了梳理和优化。

详情参见:FineDataLink支持的数据源

5)优化数据源类型的注册功能点。

详情参见:注册简介 第六章

定时任务新增内置参数并提供参数管理功能

1)新增两个内置参数:

${workname}:取当前任务名称。

${workname.jobname.opresult}:获取其他任务节点最近一次运行结果。

详情请参见:内置参数

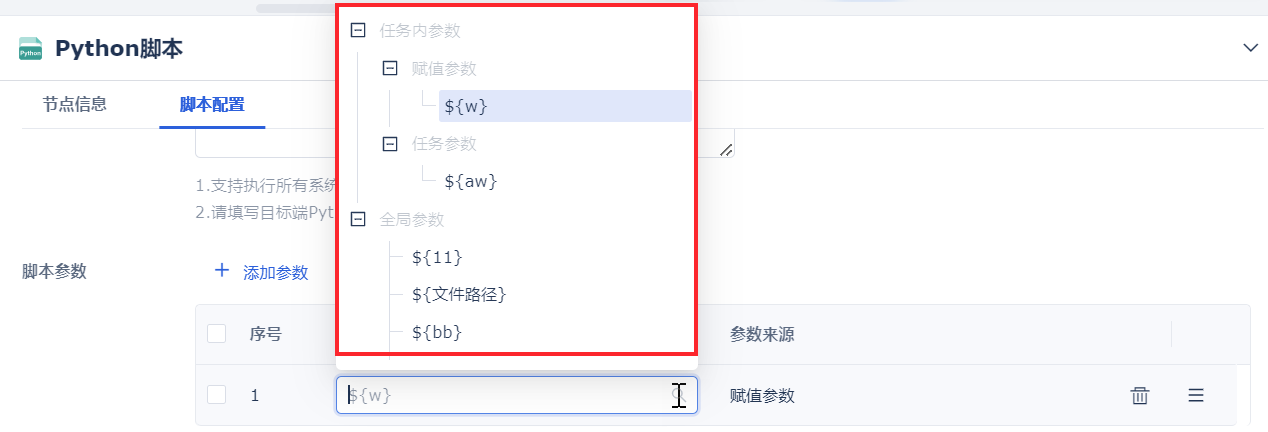

2)「参数列表」界面中,可查看该任务可用的参数。

详情请参见:自定义参数

3)任务内配置参数支持下拉选择。

数据转换新增上下合并算子

用户存在多个业务系统的表数据,这些表数据中存在相同字段或相同含义的字段,需要将不同的来源数据上下合并到一个表输出。用户目前使用「Spark SQL」算子实现,比较繁琐,希望能无代码实现。

新增「上下合并」算子,可对多张表进行上下行合并,输出一张合并表。如下图所示:

详情参见:上下合并

定时任务支持 SeaboxMPP作为读写数据源

定时任务支持读取和写入 SeaboxMPP 数据库。详情请参见:配置SeaboxMPP数据源

定时任务&管道任务&API支持导入导出

FineDataLink 工程上做好的定时任务&管道任务&API希望能够被复用到其他工程中。

1)FineDataLink 支持将定时任务从 A 系统中导出并导入至 B 系统。

详情请参见:定时任务导入导出

2)FineDataLink 支持将管道任务从 A 系统中导出并导入至 B 系统。

详情请参见:管道任务导入导出

3)FineDataLink 支持将 API 任务从 A 系统中导出并导入至 B 系统。

详情请参见:API任务导入导出

数据管道

管道任务支持仅增量同步

数据管道任务初次运行时,采取全量+增量同步策略:

全量阶段:查询任务运行时刻数据来源表的所有数据,输出至数据目标表。

增量阶段:全量同步完成后,通过监听数据管道来源端的数据库日志变化,获取数据来源表的增量数据,将增量数据变化同步至数据目标表。

当以下场景中,用户希望进增量同步:

用户源库删除留存数据后,目标库仍保留完整数据。

希望仅增量同步源表中近期有效数据。

历史数据量很大的用户,为满足数据导入时间窗和导入成功率,历史数据往往要通过特定的高速装载方式或者分多次多批导入。

新版本的管道任务支持从指定的起点开始,持续同步新增的变化数据(增删改)。如下图所示:

详情请参见:配置管道任务 3.3 节内容。

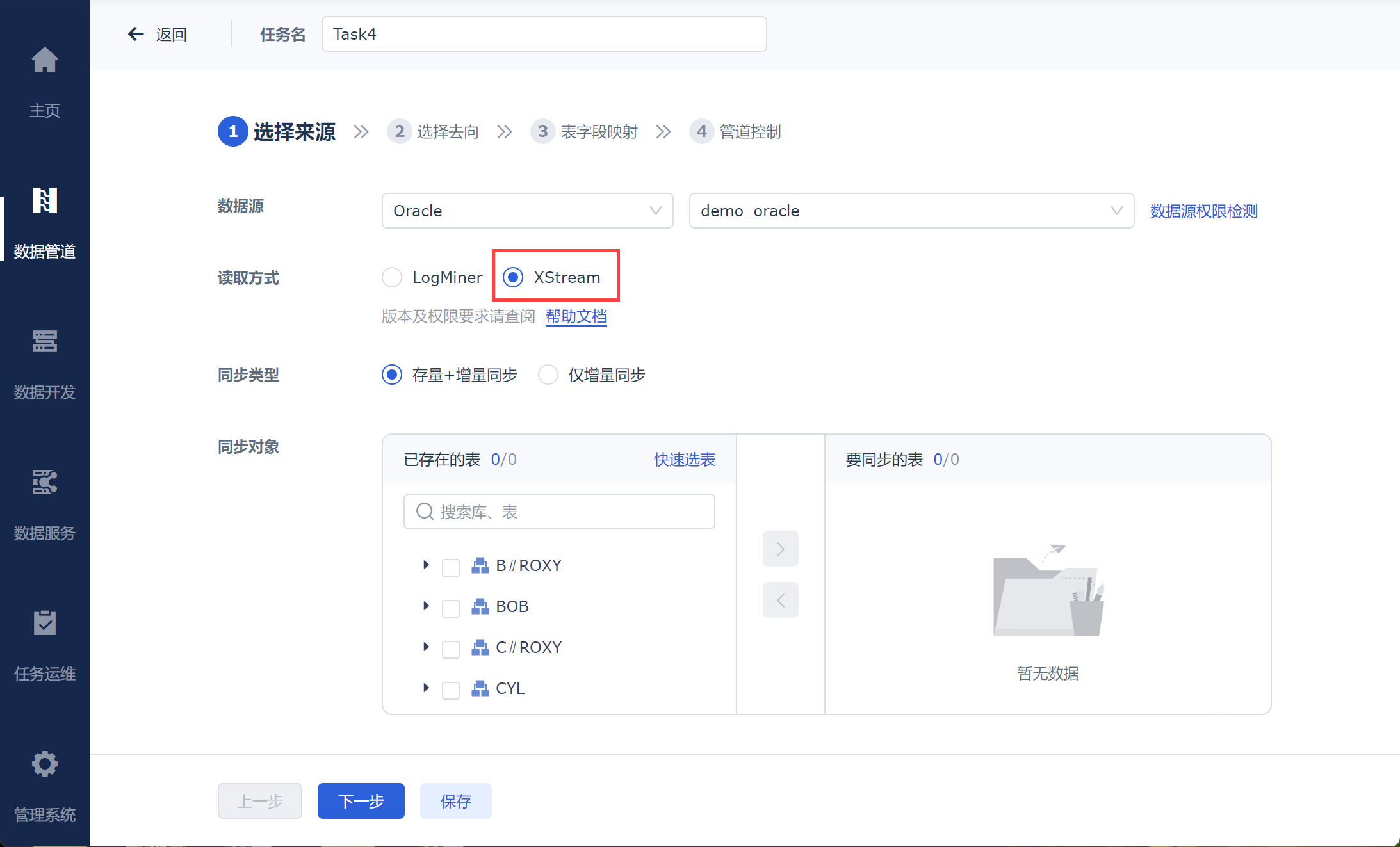

管道任务Oracle数据源支持对接XStream

CDC(Change Data Capture),即数据变更抓取,通过为源端数据源开启CDC,FineDataLink 数据管道可实现数据源的实时数据同步以及数据表的物理删除同步。

FineDataLink 数据管道支持 Oracle 的 XStream CDC 模式。

详情参见:Oracle环境准备(XStream)

数据管道和数据服务适配集群

数据管道和数据服务适配集群。详情请参见:集群部署概述

数据服务

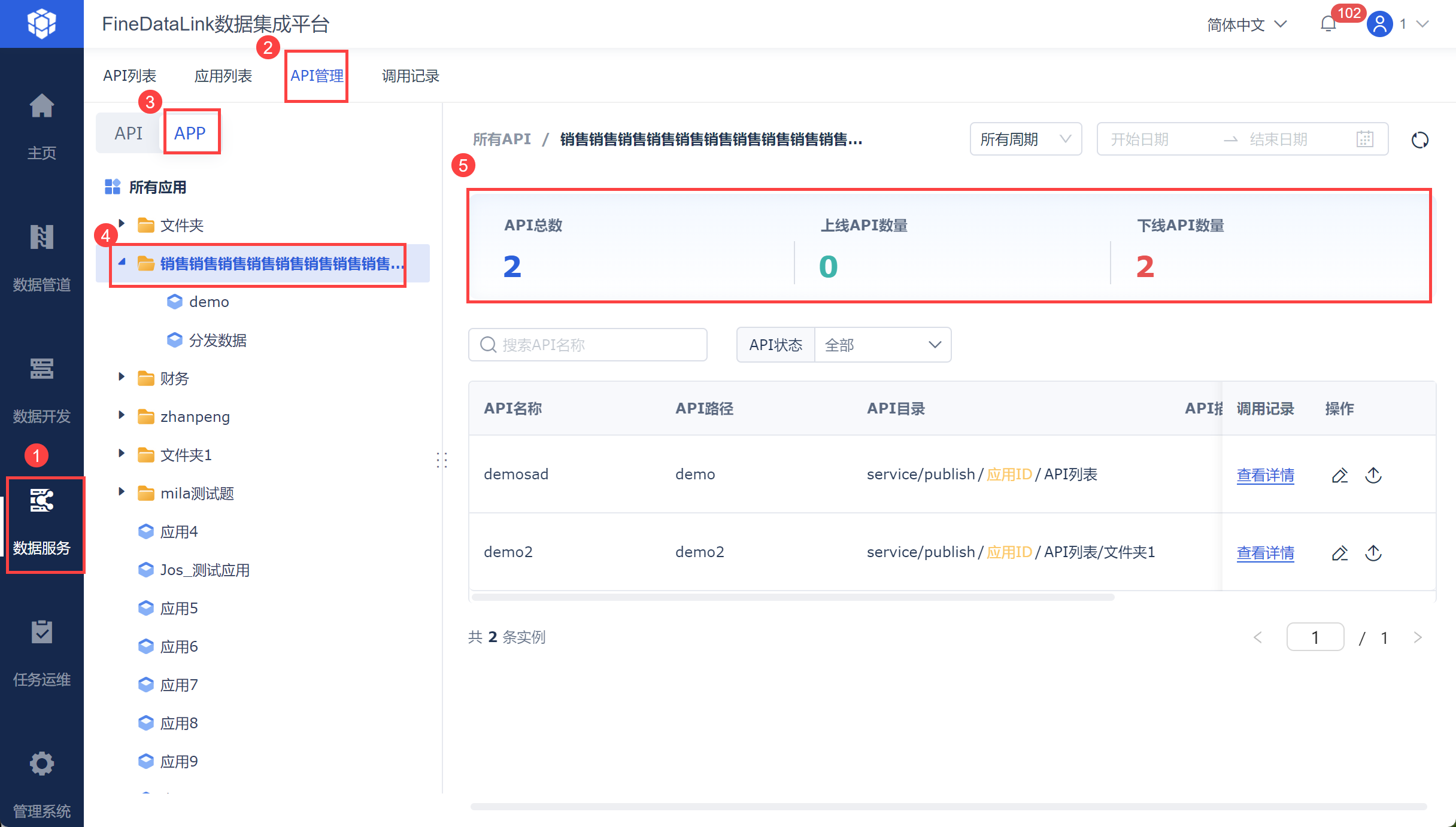

数据服务支持按照应用维度查看调用记录

支持按照应用维度查看调用记录。如下图所示:

详情请参见:服务运维 4.2 节内容。

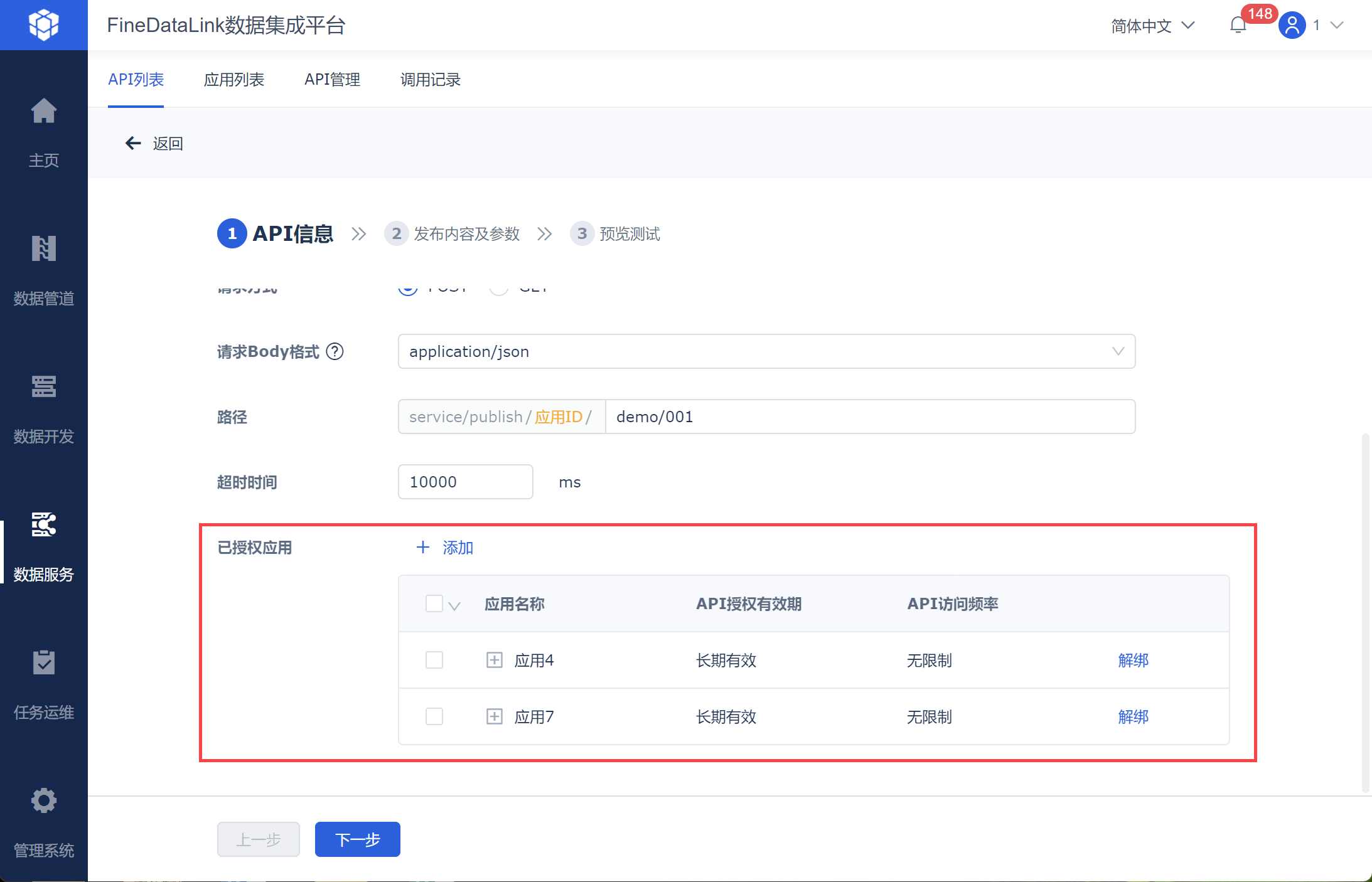

数据服务定义API时支持绑定应用和测试

用户可在创建API时将其添加至授权应用,便于后续的 API 调试和直接发布 API 进行使用。如下图所示:

详情参见:发布API概述 3.1 节。

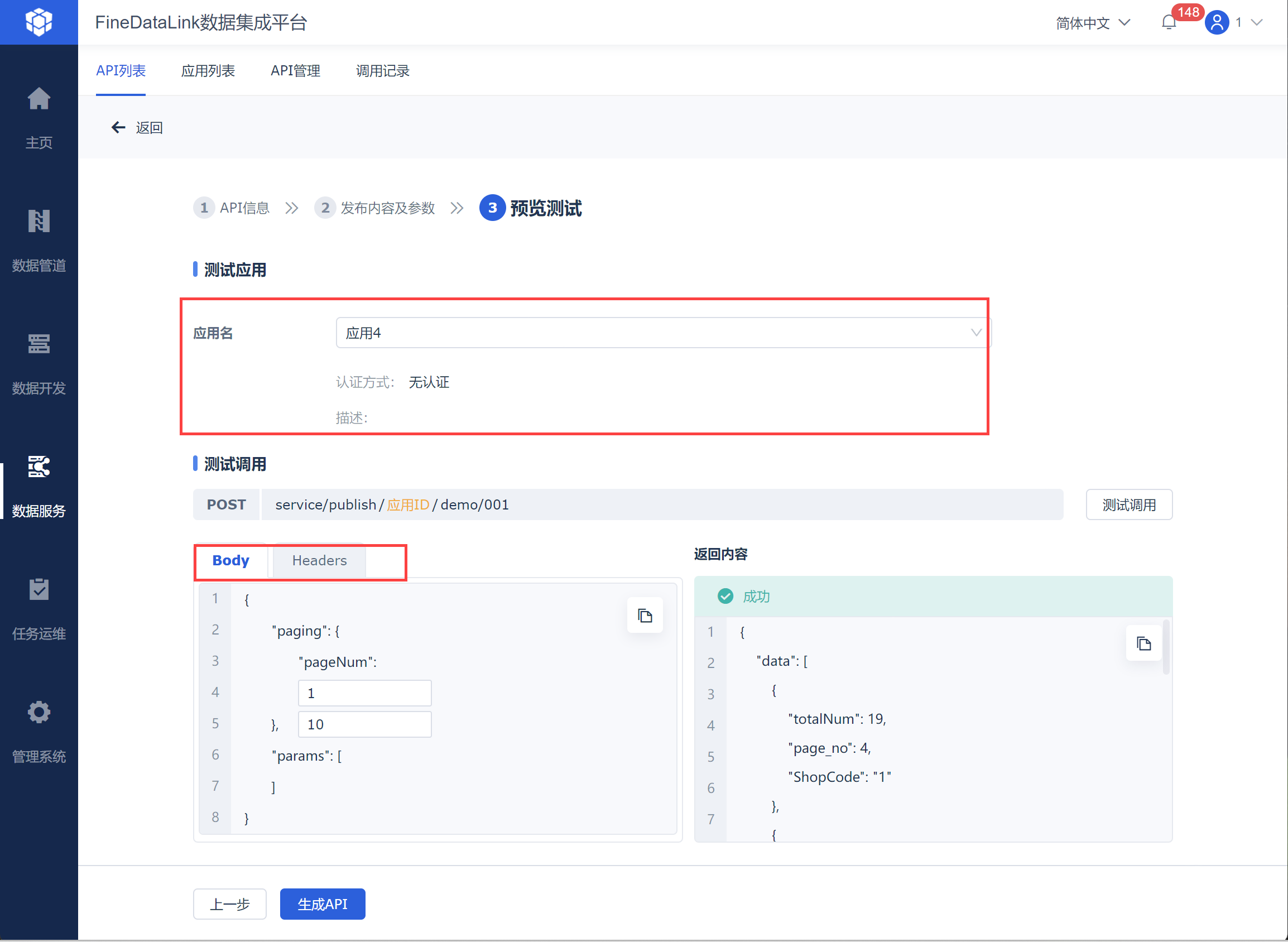

数据支持发布 API 时进行应用配置测试,便于用户直接确认 API 是否已经可用并满足需求,如下图所示:

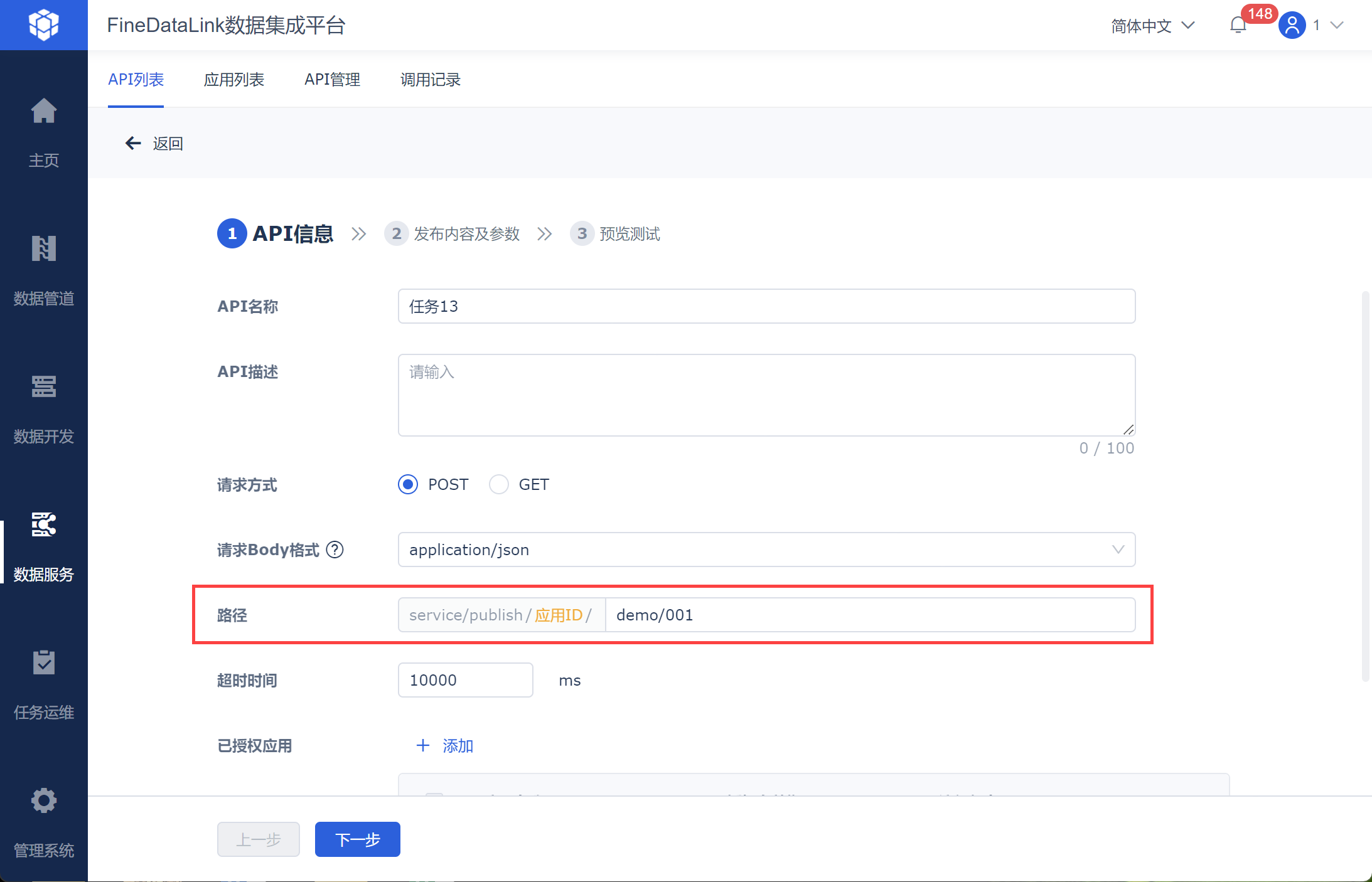

数据服务支持指定多级API路径

支持指定多级API路径,若用户想要对发布的API进行层级设计,可以使用连字符(-)、正斜杠(/)等符号设计API路径,如下图所示:

详情参见:发布API 2.2节。

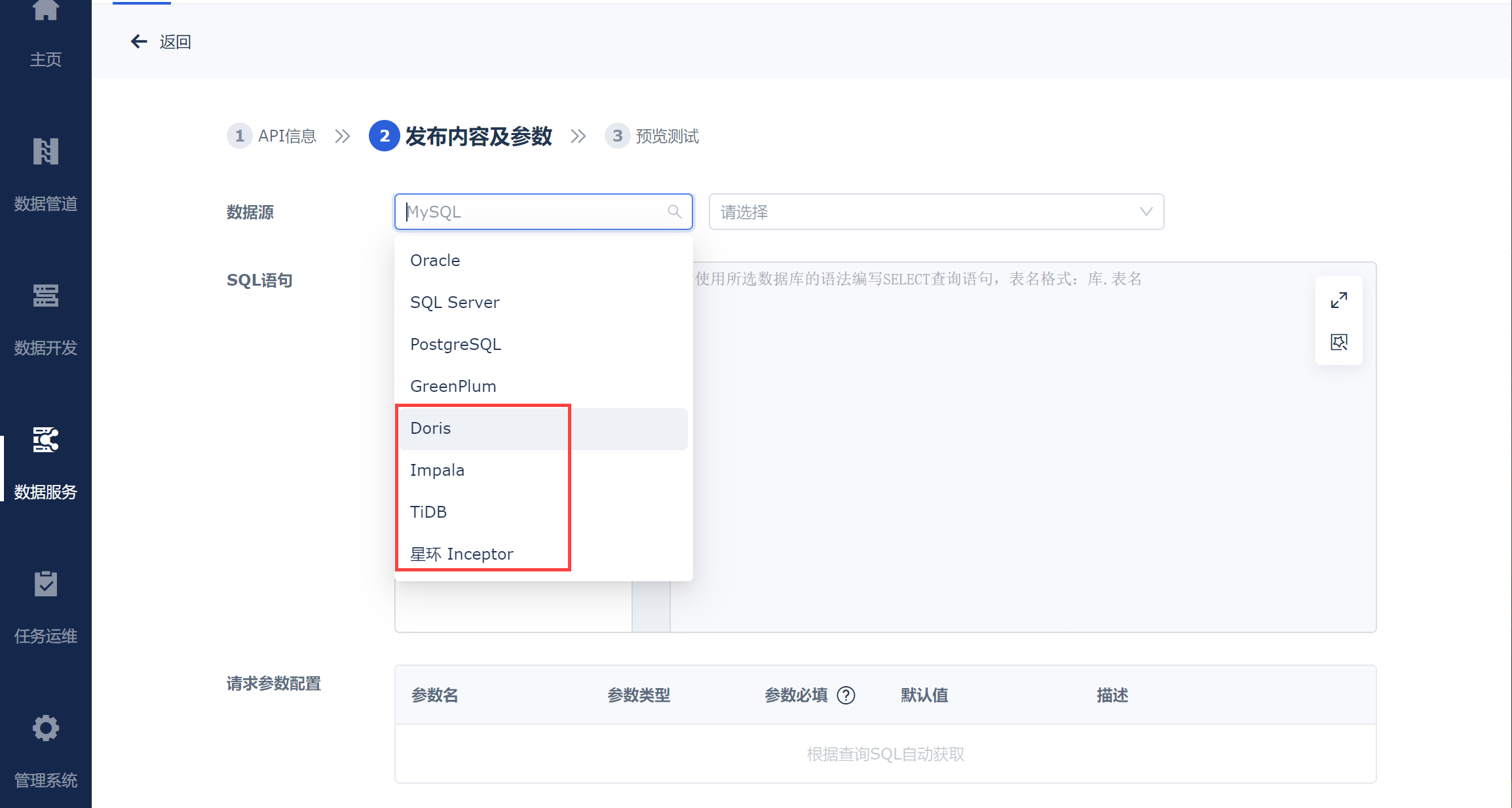

数据服务API支持发布(Doris\Impala\TiDB\星环)数据源

详情参见:发布API概述

暂时屏蔽功能

暂时屏蔽功能

4.0.30 版本,暂时屏蔽 独立部署下定时任务结果输出至FineBI 功能。

注意点

FineDataLink 适配高版本 Kafka

安全检测中测出性能漏洞,涉及 Kafka 版本 2.3.0~3.3.2 。

目前已适配 Kafka 3.5.1 版本,原有 2.x 也可以正常使用,对于一些稳定性敏感,且不需要响应安全问题的用户,可以采取稳定性优先的策略,在其他用户广泛验证后,再升级高版本 Kafka。

详情请参见:部署Kafka

注册相关

新版本功能点注册与老版本中控制逻辑不一致,新版本:

1)删除数据开发整个模块是否注册是由「调度配置」功能点控制

2)数据管道是由「管道任务」、「数据监控及补全」两个功能点共同控制,即需要两个都要注册,才算数据管道整个模块注册

3)由「步骤流程-基础节点包」控制「数据开发」是否注册,将原本「调度配置」、「任务运维」的功能点控制都移到「步骤流程-基础节点包」中

由「数据服务-基础」控制「数据服务」是否注册

由「管道任务」控制「数据管道」是否注册

4)功能点也进行了修改。

原「接口协议」功能点改为「接口协议(定时)」包含 API、WebService

原「无结构化数据存储」功能点改为「文件系统」包含 FTP/SFTP、本地文件

新增 应用连接器(定时) 包含简道云、SAP RFC

新增消息队列 包含 kafka

定时任务

参数赋值节点+循环容器节点使用场景中,若「参数赋值」节点输出参数的分隔符选择「文本型分隔」,在循环容器内使用时加了单引号,升级到 4.1.0 及之后版本时,需要手动去掉单引号。