产品新功能编辑

数据开发

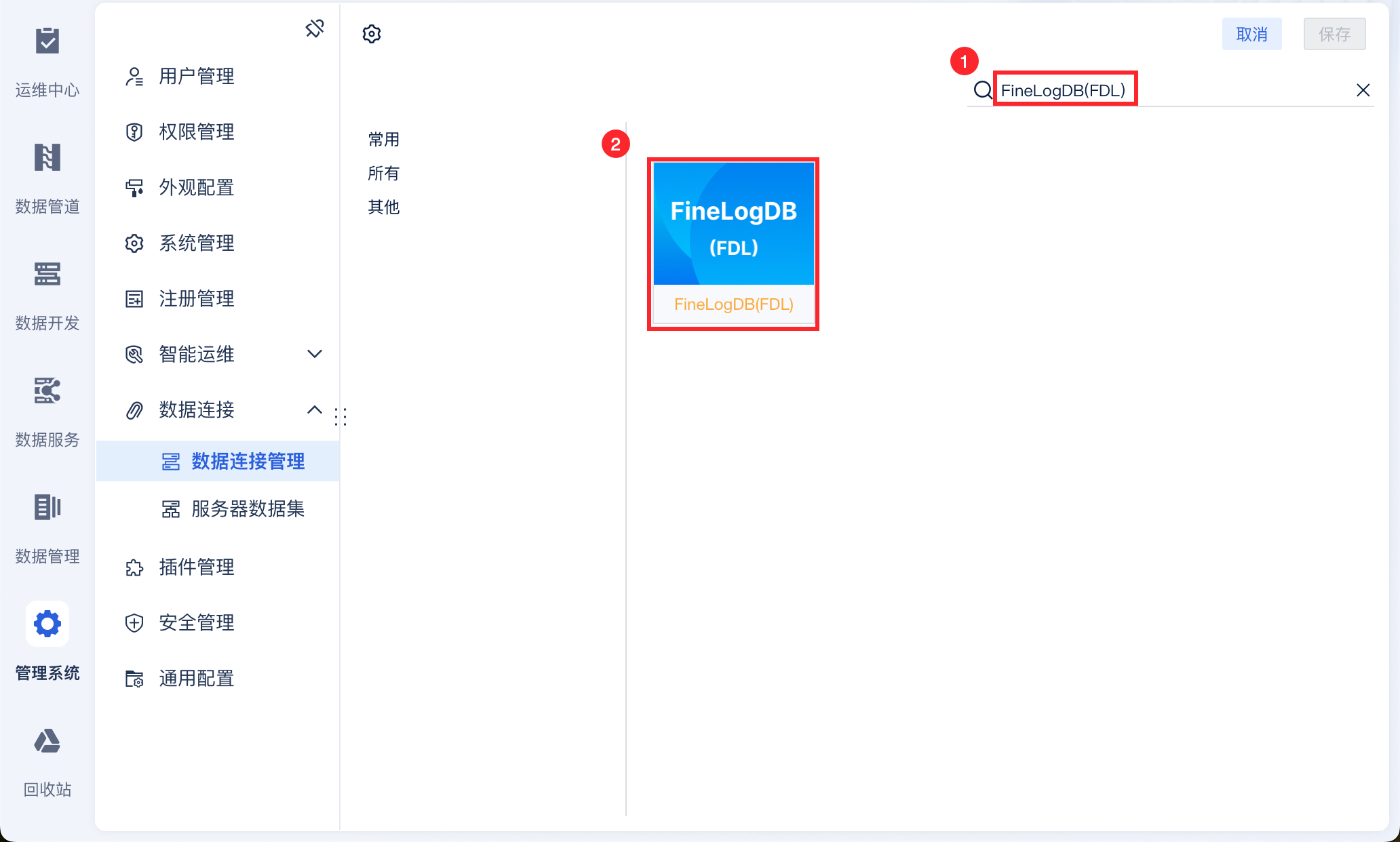

定时任务支持读取 FineLogDB(FDL) 数据

用户希望同步 FineDataLink 的 LogDB 数据到指定数据库,然后报表使用这些数据制作看板。

FineDataLink 支持连接 FineLogDB(FDL) 数据源进行定时任务读取。

详情请参见:配置 FineLogDB(FDL) 数据源

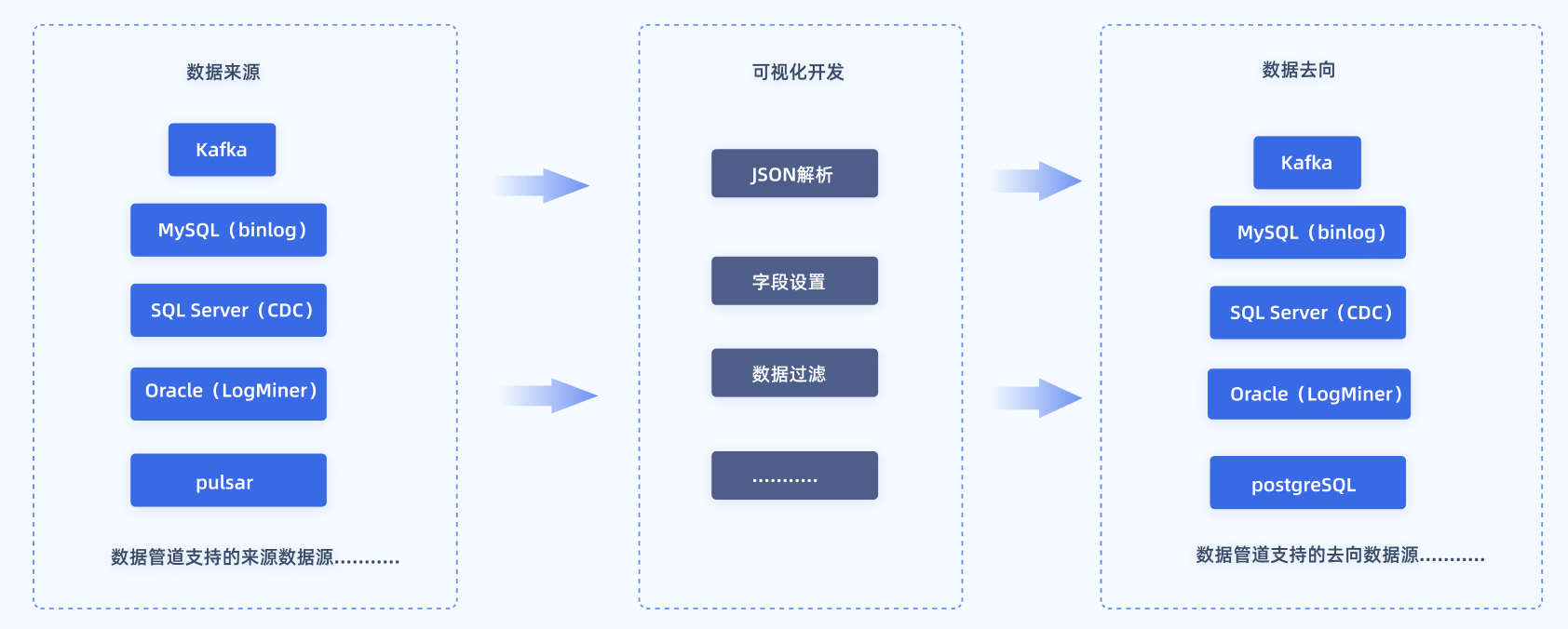

支持实时任务

实时任务能够实时地把数据从 A 点投递到 B 点。在投递的过程中可能添加数据清洗的工作,例如实时数仓中的数据解析等。最终结果可供后续业务使用,以提高数据利用率和时效性,满足业务需求。

详情请参见:实时任务概述

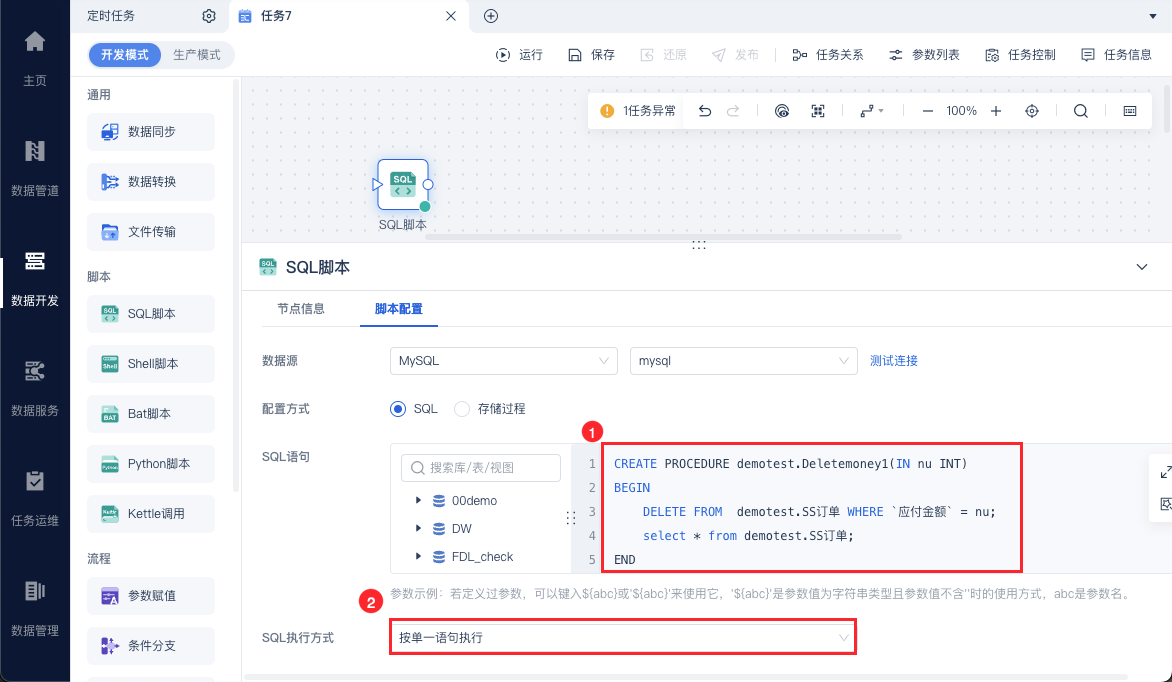

定时任务SQL脚本支持执行单条SQL和多条SQL

可以对SQL脚本设置是否进行切割发送到数据库进行执行,如下图所示:

详情请参见:SQL脚本

事件调度判断条件优化

支持设置当前任务执行的条件,并配置上下游任务组

支持重试当前任务以及下游任务,根据「事件调度」中配置的任务关系&条件内容,判断下游任务是否触发。

详情请参见:事件调度

功能模块适配更多数据源

定时任务写入优化

1)定时任务支持写入MaxCompute。详情请参见:MaxCompute数据源使用说明、配置MaxCompute数据源

2)定时任务支持写入Elasticsearch。详情请参见:Elasticsearch输出、配置Elasticsearch数据源

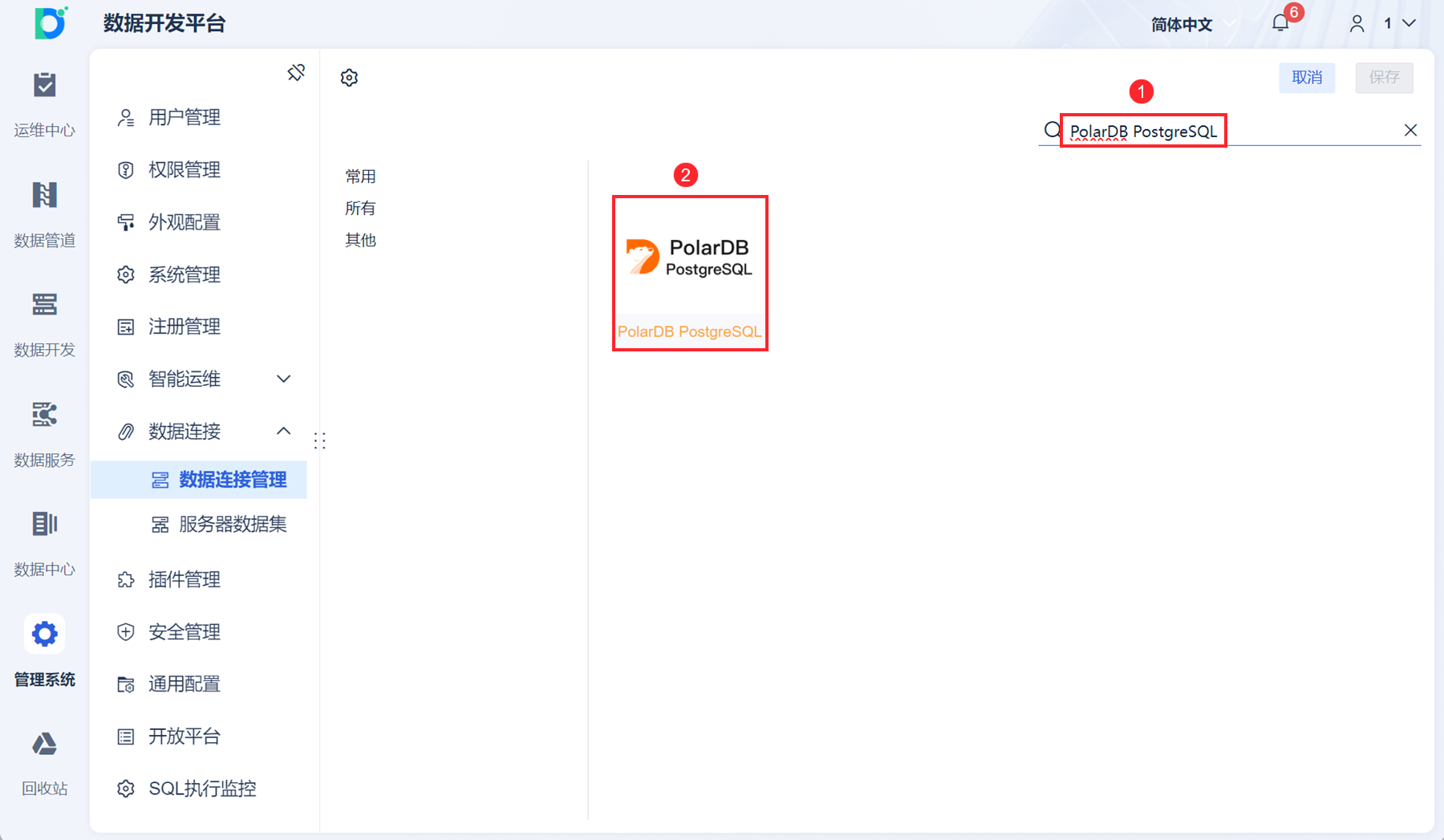

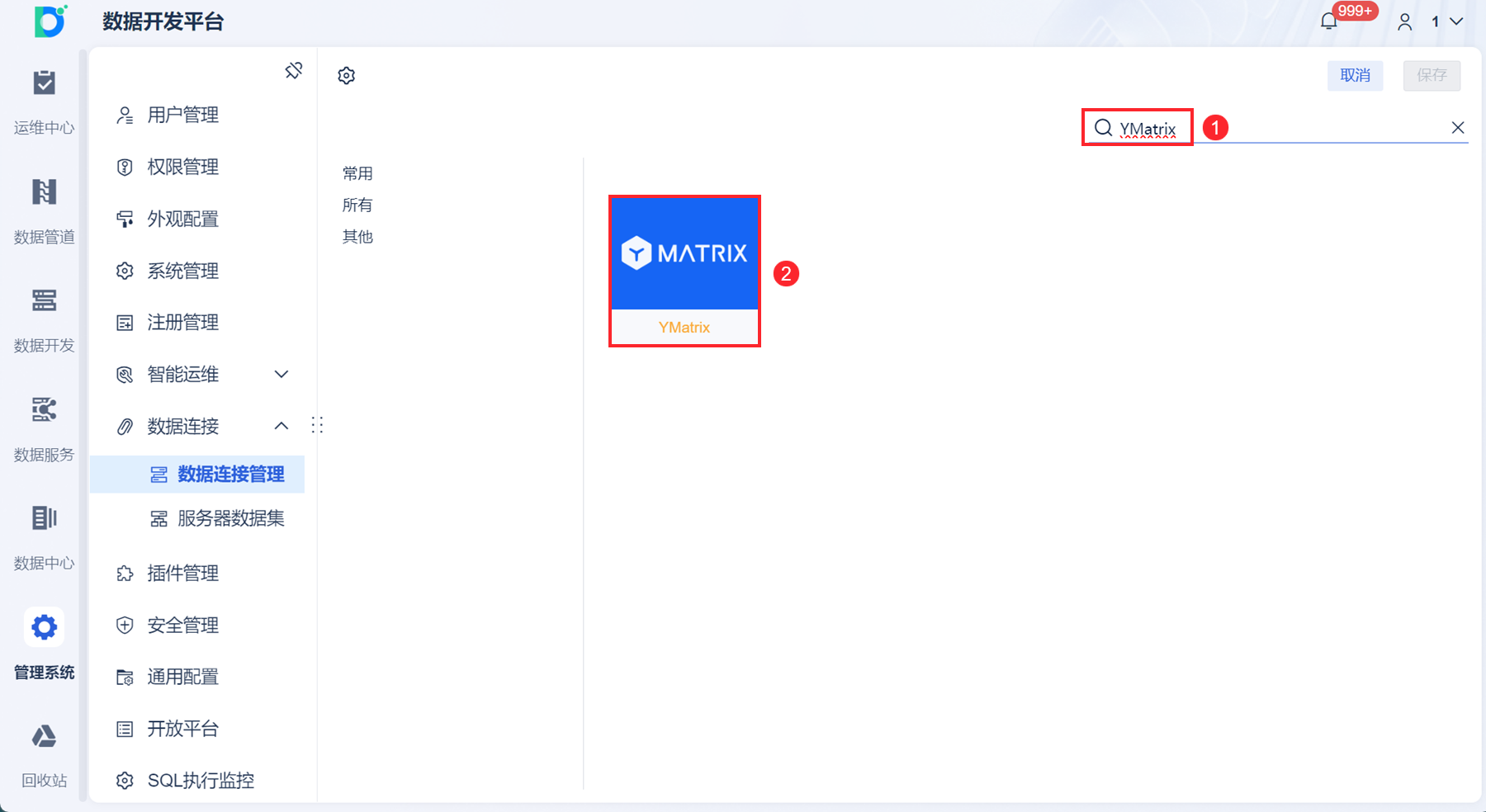

数据管道写入&定时任务读写&数据服务读支持 PolarDB PostgreSQL、YMatrix

1)详情请参见:配置PolarDB PostgreSQL数据源

2)FineDataLink 支持连接 YMatrix 数据库,进行定时任务读写、管道任务写入,以及作为数据服务数据发布源。

详情请参见:配置YMatrix数据源

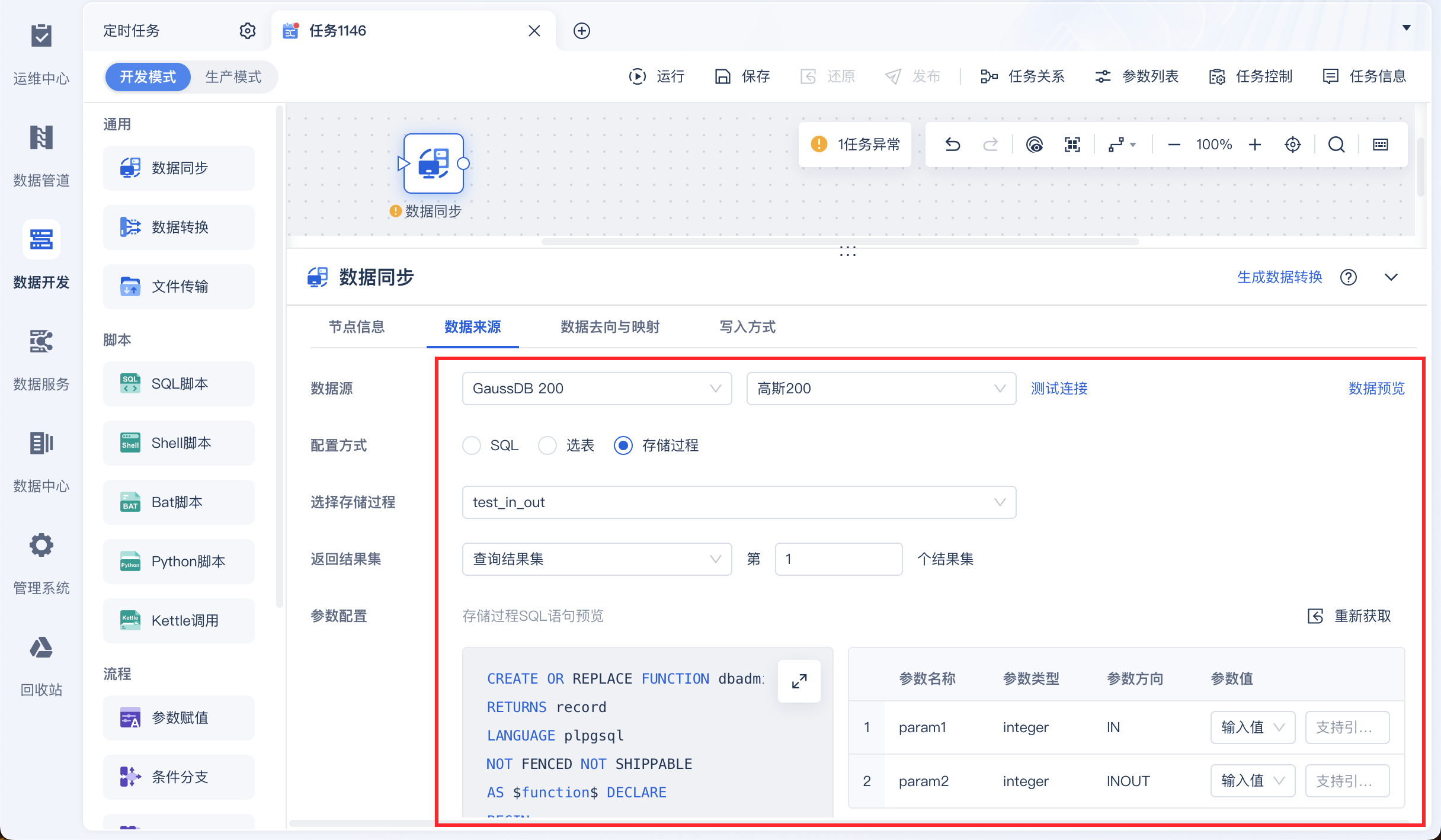

定时任务调用存储过程支持vertica和高斯200

HP Vertica 和 GaussDB 200 支持使用「SQL脚本」调用无返回值的存储过程。

GaussDB 200 支持存储过程表输入,可使用「数据同步/数据转换/参数赋值」返回存储过程单个查询结果集作为表输入,不支持返回游标结果集。

详情请参见:定时任务调用数据库存储过程

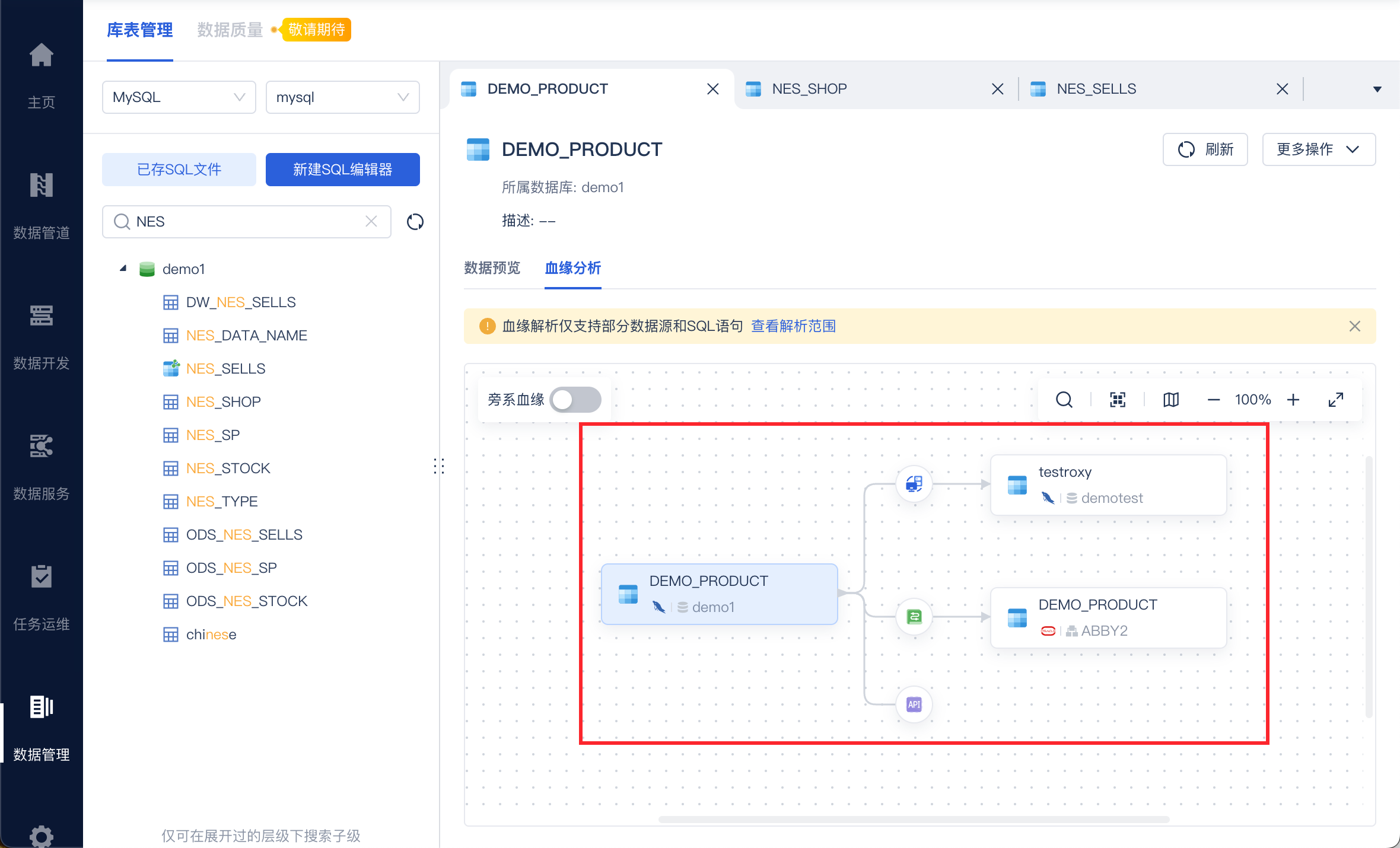

血缘分析支持Greenplum

来源端为「SQL」配置项支持 Greenplum 数据源。

详情请参见:血缘分析

数据管理编辑

文档上新编辑

客户案例

PI数据库API循环取数

应用场景:

本文讲述如何从 PI 数据库取数。

参考文档:

详情请参见:PI数据库API循环取数

多个逗号分隔的字段按照分组顺序匹配

应用场景:

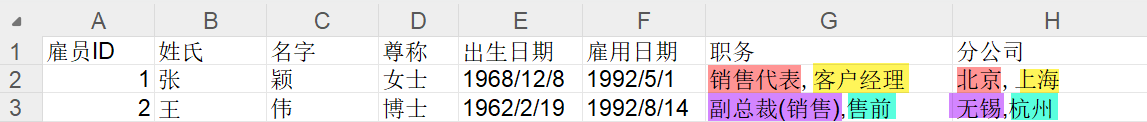

从接口取数后,数据保存格式为:{{主数据},{子数据1,子数据2}{子数据a,子数据b}};其中,子数据中包含多个字段,以逗号分割存储。如下图所示:

实际业务场景中,每个子数据相当于一个分组,希望所有子数据按照分组内的数据顺序进行匹配(上图相同颜色的在同行展示)。希望得到的数据如下图所示:

使用两个「字段拆行」算子分别拆分职务、分公司字段时,出现笛卡尔积。如下图所示:

黄色标记的字段非实际需要数据。

参考文档:

详情请参见:多个逗号分隔的字段按照分组顺序匹配

功能使用指导

FineDataLink与Kettle的区别

应用场景:

很多新手用户使用 FDL 前,想了解 FDL 与 Kettle 的区别。

参考文档:

详情请参见:FineDataLink与Kettle的区别

「包含」和「属于」的区别

应用场景:

条件判断逻辑说明 文档中,简单介绍了属于、不属于、包含、不包含这四种条件判断逻辑;很多用户不清楚属于与包含、不属于与不包含的区别,本文将对此进行详细解释。

参考文档:

详情请参见:「包含」和「属于」的区别

不同写入方式效果说明

应用场景:

数据同步-写入方式 文档中,介绍了三种写入方式:直接将数据写入目标表、清空目标表,再写入数据、基于标识字段,新增/修改/删除数据。

本文为您展示这三种写入方式的实际效果。

参考文档:

详情请参见:不同写入方式效果说明