目录:

1. 概述编辑

「数据开发>定时任务」模块支持在可视化界面使用各个节点和算子进行数据的抽取、转换和装载,并可以通过定时调度功能自动运行定时任务,帮助您轻松构建离线数仓,保证数据生产的高效稳定。

本文为您说明「定时任务」模块的能力。

2. 多源异构数据高效整合、处理编辑

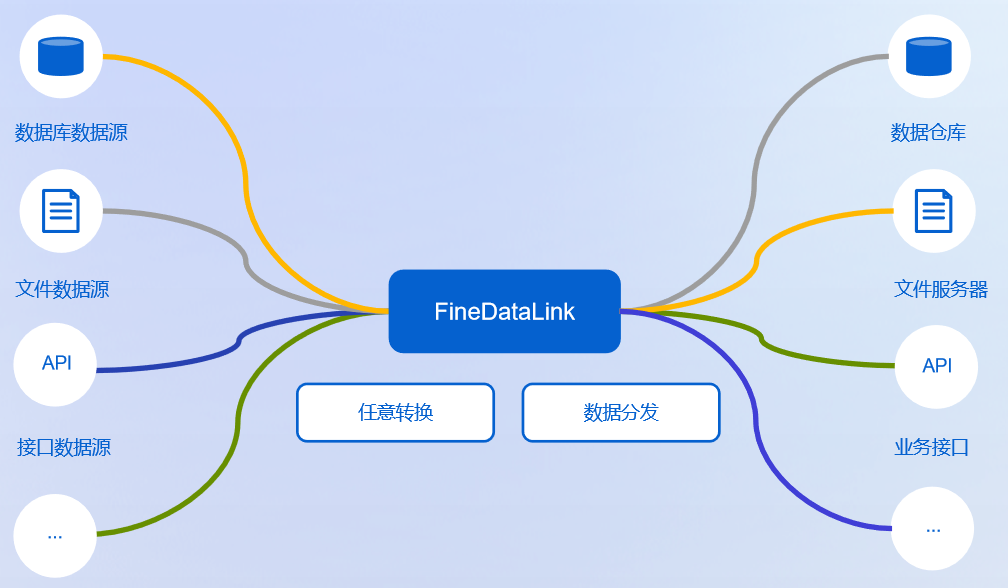

2.1 任意终端到任意终端

2.1.1 功能说明

详情请参见:定时任务支持的数据源范围

第一列和第二列的数据源可以任意排列组合,例如:读取文件类型数据,数据经过处理后(选做),保存到数据库

| 支持读取的数据源 | 支持写入的数据源 | 备注 |

|---|---|---|

| 数据库 | 数据库 | - |

接口类型数据(API、WebService) | 接口类型数据(API) 暂不支持写入 WebService | FDL 中 API 相关功能请参见:API专题 |

| 文件数据(CSV、Excel、txt等) | 文件数据(CSV、Excel、txt等) | FDL 中文件数据相关功能请参见:对接文件数据专题 |

| BI公共数据 | BI公共数据 | 数据集输出 |

| 服务器数据集 | 不支持服务器数据集 | - |

| 大数据平台(SAP HANA、Impala、Greenplum等) | 大数据平台(SAP HANA、Greenplum、ClickHouse等) | - |

连接器(简道云、SAP RFC) | 连接器(简道云) 暂不支持写入SAP RFC | 简道云数据处理请参见:对接简道云专题 |

2.1.2 其他说明

| 分类 | 说明 |

|---|---|

| 来源端读取多张表数据 | 1)上下合并、数据关联 算子中,支持将两张不同的表数据进行合并 2)SQL脚本 中,支持写 SQL 语句处理多张表数据 |

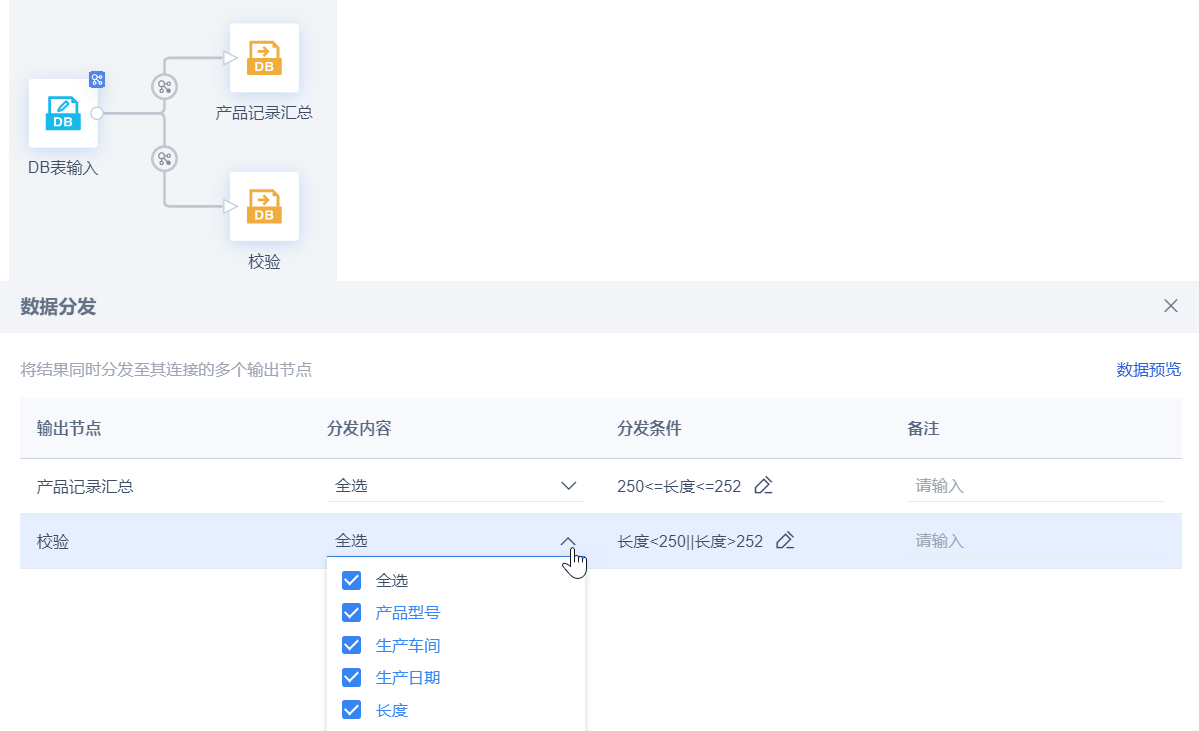

| 数据输出到多张表★★★★★ | 数据分发 功能,支持将处理好的数据,保存到多张表。如下图所示:

|

| 读取、创建、写入分区表 | 大数据量的数据存储场景下,为提高查询性能,许多数据库都提供了分区表的功能,希望 FDL 可以读取、创建、写入分区表。详情请参见:读取、创建、写入分区表 |

| 调用数据库存储过程 | 定时任务中,支持调用数据库存储过程。详情请参见:定时任务调用数据库存储过程 |

| 定时任务相关接口支持被调用★★★★★ | 详情请参见:调用定时任务相关接口说明 |

| 支持将数据写入到 FineBI 「公共数据」指定目录下★★★★★ | 详情请参见:数据集输出 |

2.2 任意结构转化为任意结构

结构化数据、半结构化数据、非结构化数据之间可以任意转换。

示例:

2.3 数据清洗

针对原始数据进行清洗,统一数据口径。

| 分类 | 说明 | 参考文档 |

|---|---|---|

| 数据清洗★★★★★ | 可对数据进行处理的节点、算子★★★★★ | 节点介绍 |

| 数据清洗专题 | 多流数据合并、运算专题 | |

| 「Spark SQL」算子中支持使用的语法 | SparkSQL语法概述 | |

| 处理数据的函数说明 |

2.4 数据更新

数据更新方式为三种:增量更新、全量更新、比对更新,具体实现方案请参见:数据同步方案概述

注:可使用 数据比对算子 ,进行数据的一致性检测,即对比来源和目标数据的一致性。

2.5 数据融合

针对不同类型的异构数据进行融合,完成数据关联、维度建模,具体功能可参见:上下合并、数据关联、SQL脚本、Spark SQL

2.6 数据预警

关键业务数据,达到阈值情况下即时提醒,具体功能可参见:消息通知

定时任务运行失败也可进行提醒,具体请参见:任务控制-结果通知

2.7 数据分享

注:数据服务 功能可将数据输出为接口形式,供其他系统调用。

可将数据输出为文件形式进行保存;详情请参见:文件输出算子功能说明、文件传输功能说明

2.8 内容扩展

1)当进行定时任务开发时,能够提示来源端数据表的 DDL 变化,并且将变化通知给指定用户。详情请参见:定时任务DDL同步

2)更多实际应用请参见(多节点、算子配合使用实现复杂场景;API取数最佳实践;与FR、BI、简道云配合使用案例等):最佳实践合集

3)支持基于数据血缘关系回溯整个数据的生产过程,在修改数据表时,能够知晓影响范围。详情请参见:血缘分析

4)提供 Web 端 库表管理 功能,可视化管理各数据源数据;针对性搜索库表内容,快速了解数据情况。

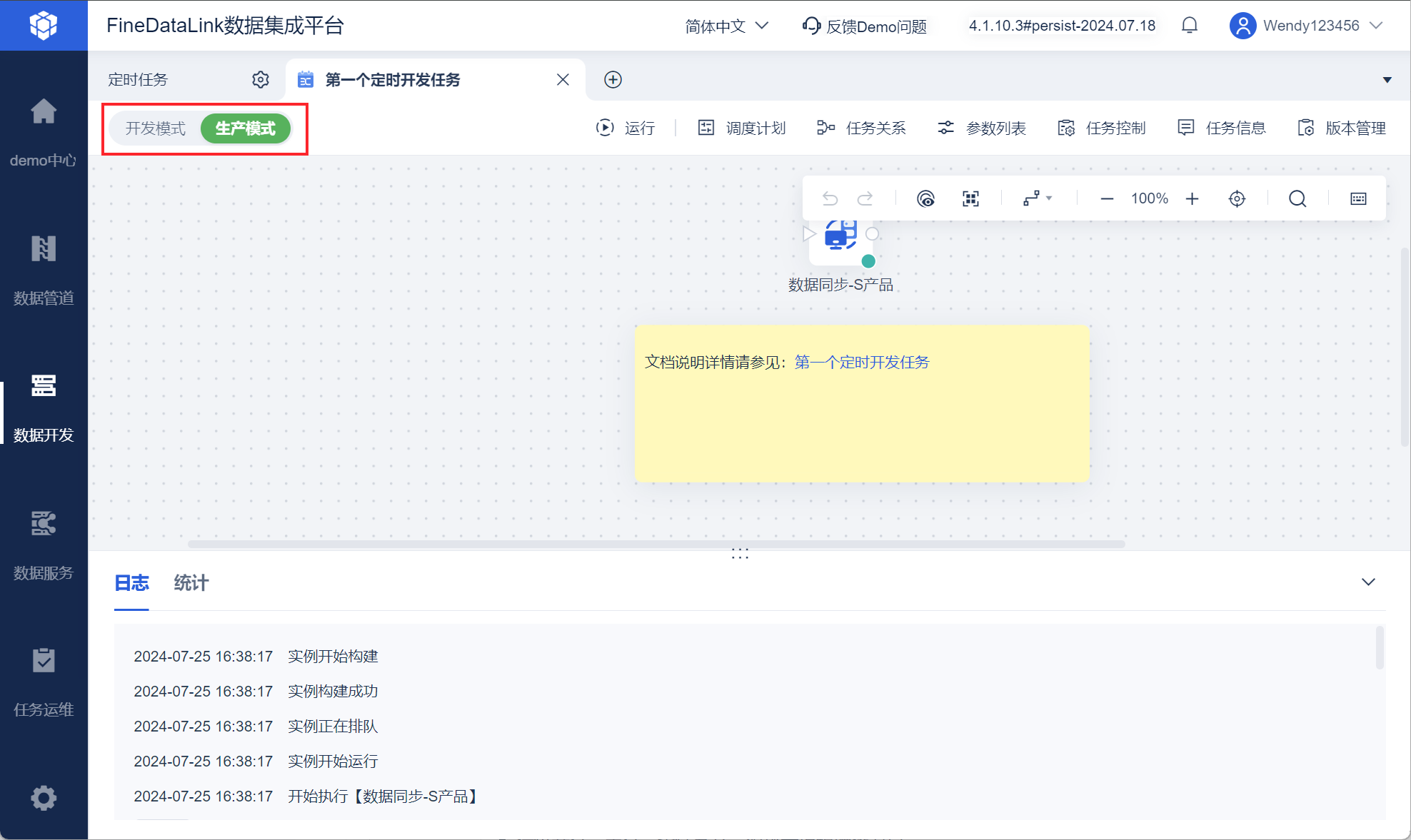

3. 开发与运行互不影响编辑

4. 画布式开发模式:开发高效、维护简单编辑

注:数据同步于数据转换的区别请参见:数据同步与数据转换的区别

| 分类 | 说明 |

|---|---|

| 步骤流 |

步骤流示例:

|

| 数据流 |

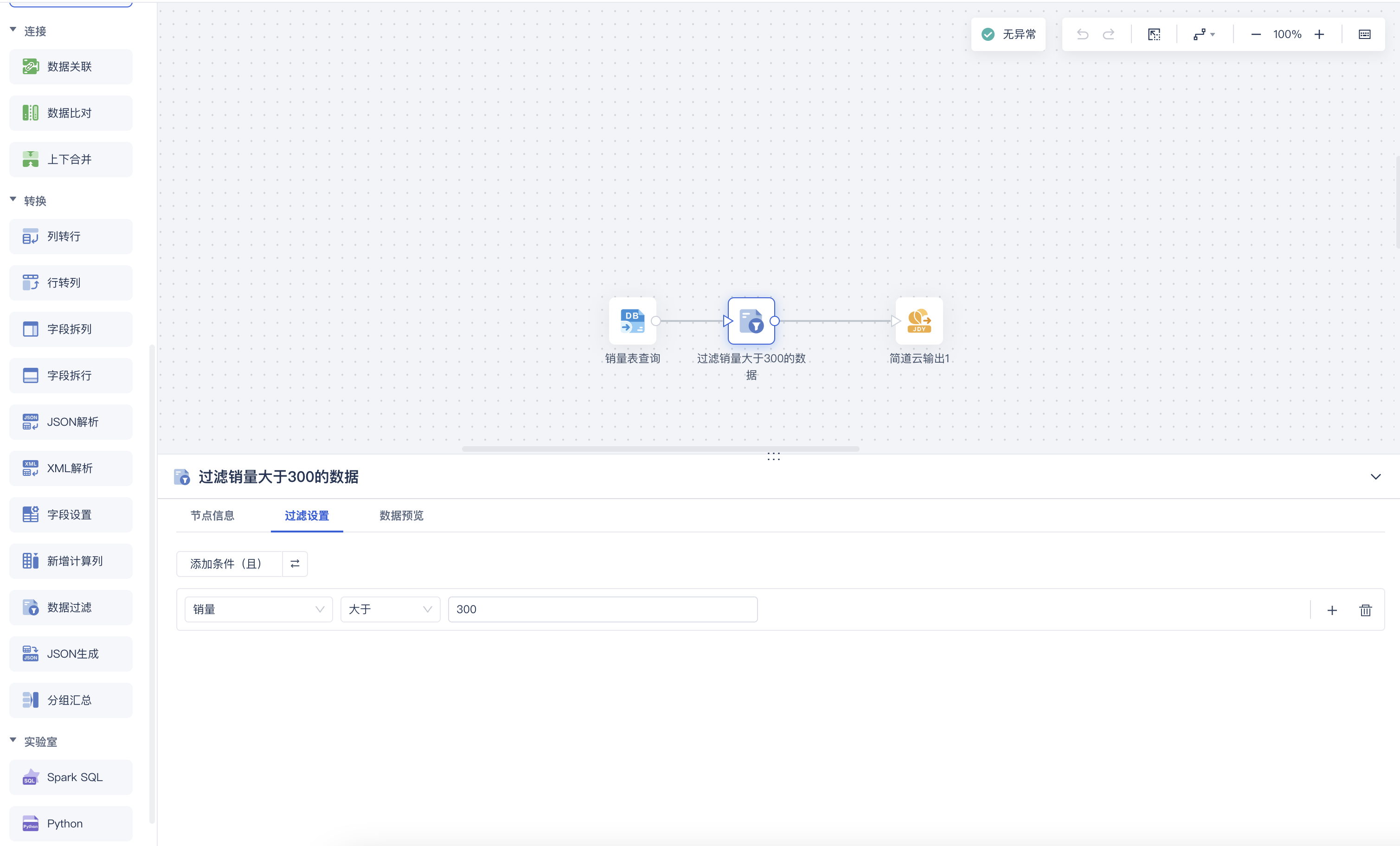

数据流可灵活满足所有数据清洗和转换场景:

|

5. 单个定时任务管理编辑

5.1 多种调度策略自由组合,满足个性化调度需求

提供按照时间周期,按事件依赖关系,触发式三种模式的调度策略,支持不同策略的灵活组合,满足不同场景的调度需要。

详情请参见:调度计划

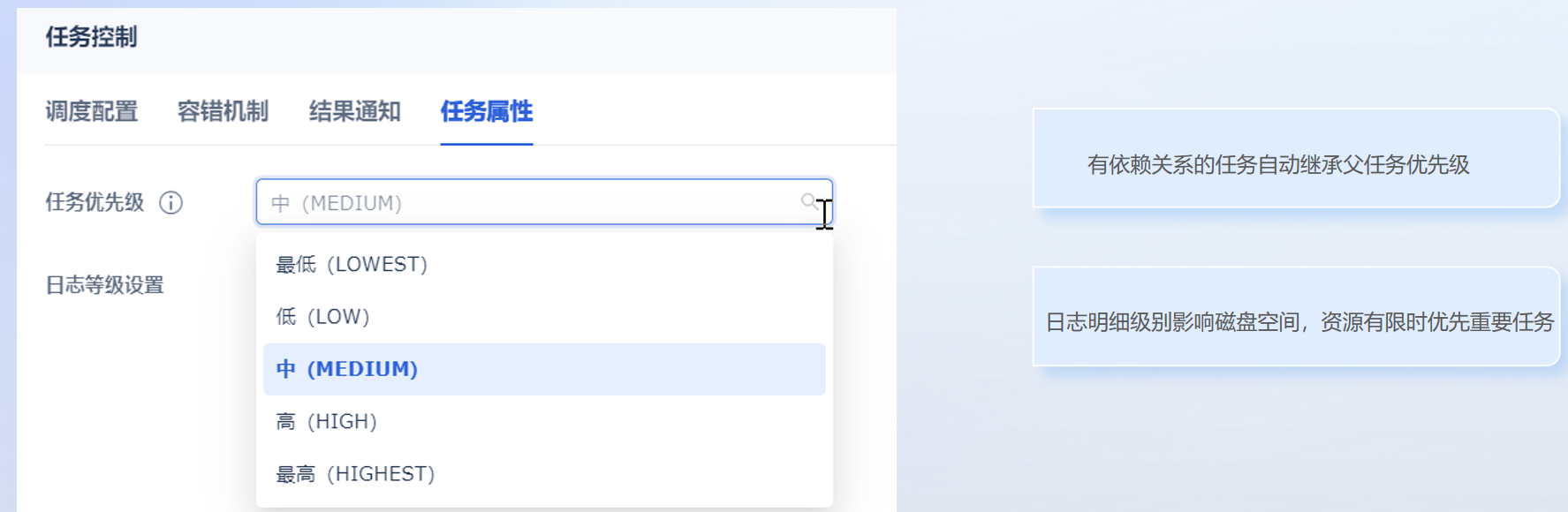

5.2 单个任务支持设置优先级

可根据业务数据重要程度设定优先级,以及日志明细级别,重要业务重点保障。

详情请参见:任务控制-任务属性

5.3 任务运行提供容错机制

FineDataLink提供超时中断、任务失败后自动重跑、以及脏数据容忍等容错机制,当遇到网络波动或少量脏数据等可控的风险,平台将自动执行重试机制,保障数据任务正常运转。

详情请参见:任务控制-容错机制

5.4 任务执行失败进行通知

任务执行失败后,可通知相关人员任务执行失败。

通知渠道:平台、邮件、短信、钉钉群机器人、飞书群机器人、企业微信群机器人。

通知内容:任务异常通知、脏数据通知、源表结构变化通知。

详情请参见:任务控制-结果通知

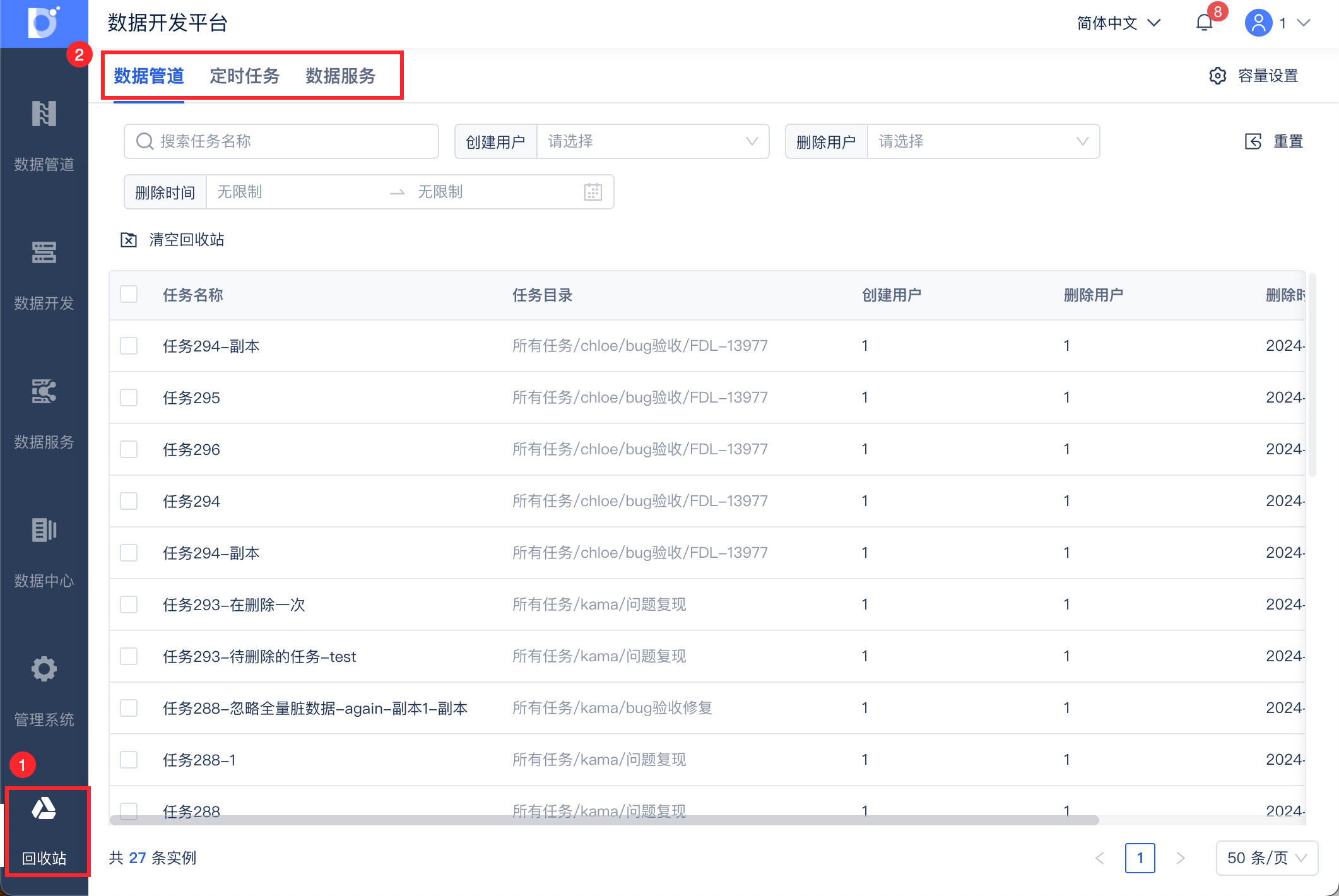

5.5 避免任务误删,提供回收站功能

回收站支持对「数据开发>定时任务」、「数据管道」、「数据服务」中已经删除的任务进行资源还原、彻底删除等。

详情请参见:回收站

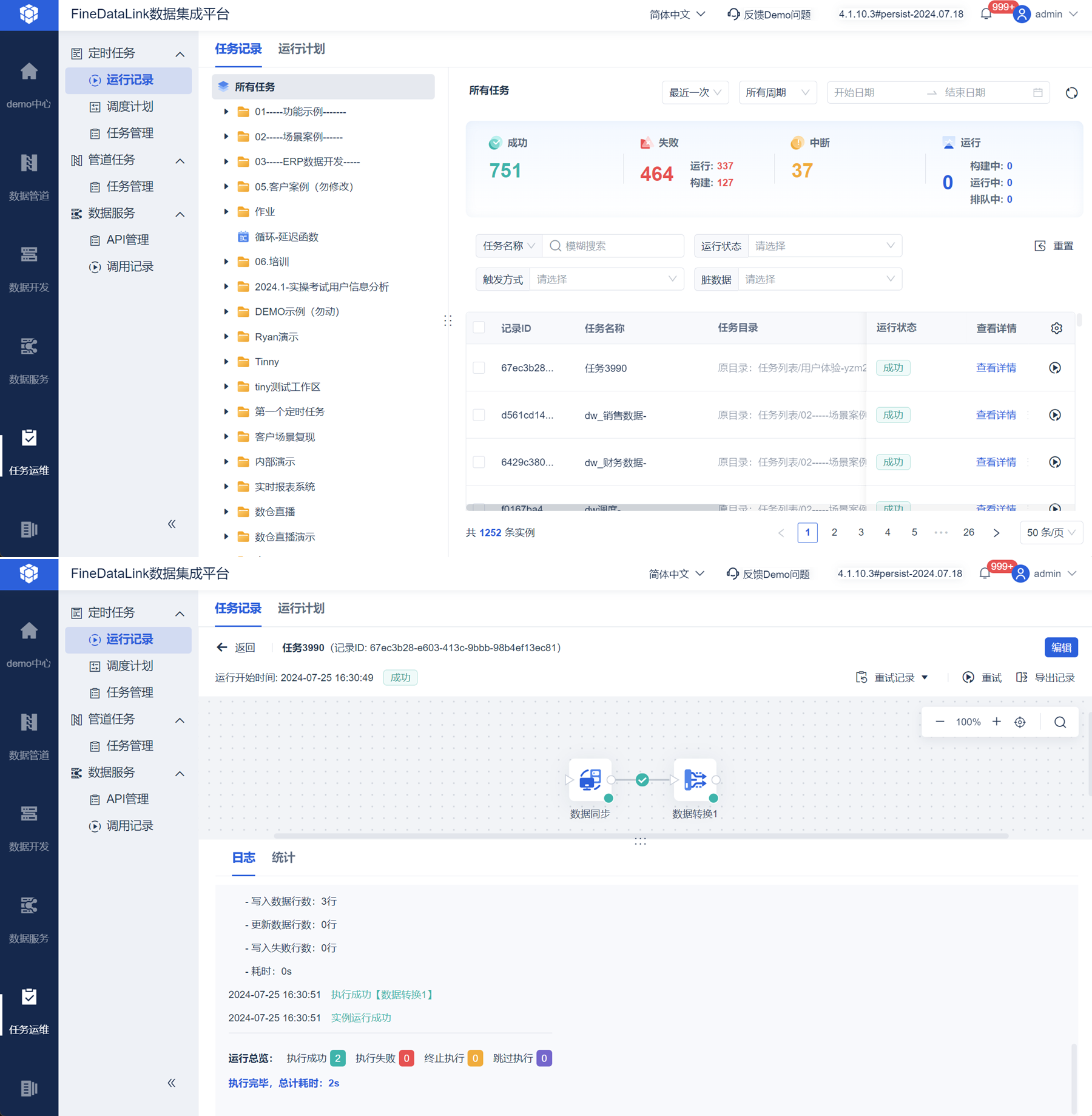

6. 批量定时任务运维编辑

1)实时进行任务运维监控管理,可查看定时任务的运行状态、任务耗时、触发方式等;支持重试定时任务(适用于补数据场景;出现脏数据导致写入失败,脏数据解决后,再次执行任务场景)。

详情请参见:运行记录

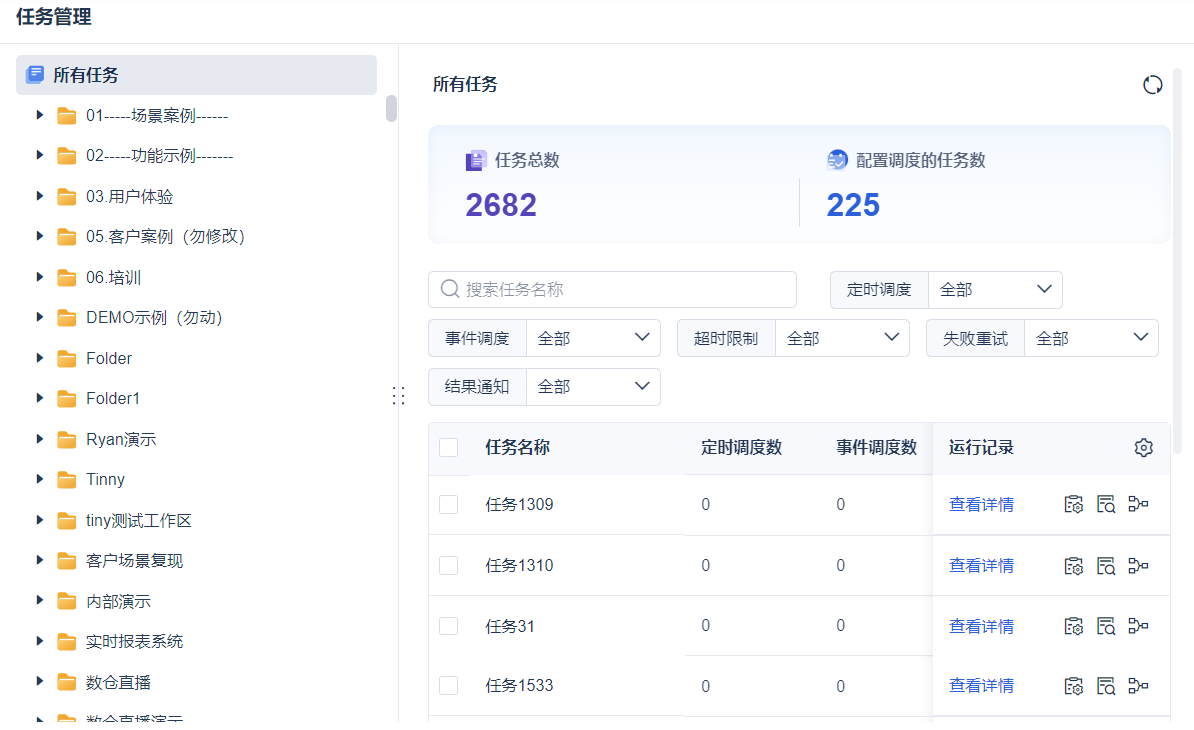

2)支持为多个/单个定时任务设置执行频率、修改和删除任务的执行频率;支持为多个/单个定时任务设置事件调度、修改和删除任务的事件调度。

详情请参见:调度计划

3)支持查看定时任务数量和任务调度状态以及调度执行情况;可批量设置结果通知。

详情请参见:任务管理

4)在独立部署时,可控制定时任务所占用的内存资源。

4.1.4 之前版本请参见:定时任务运维-资源控制;4.1.4 以及之后的版本详情参见:负载分配

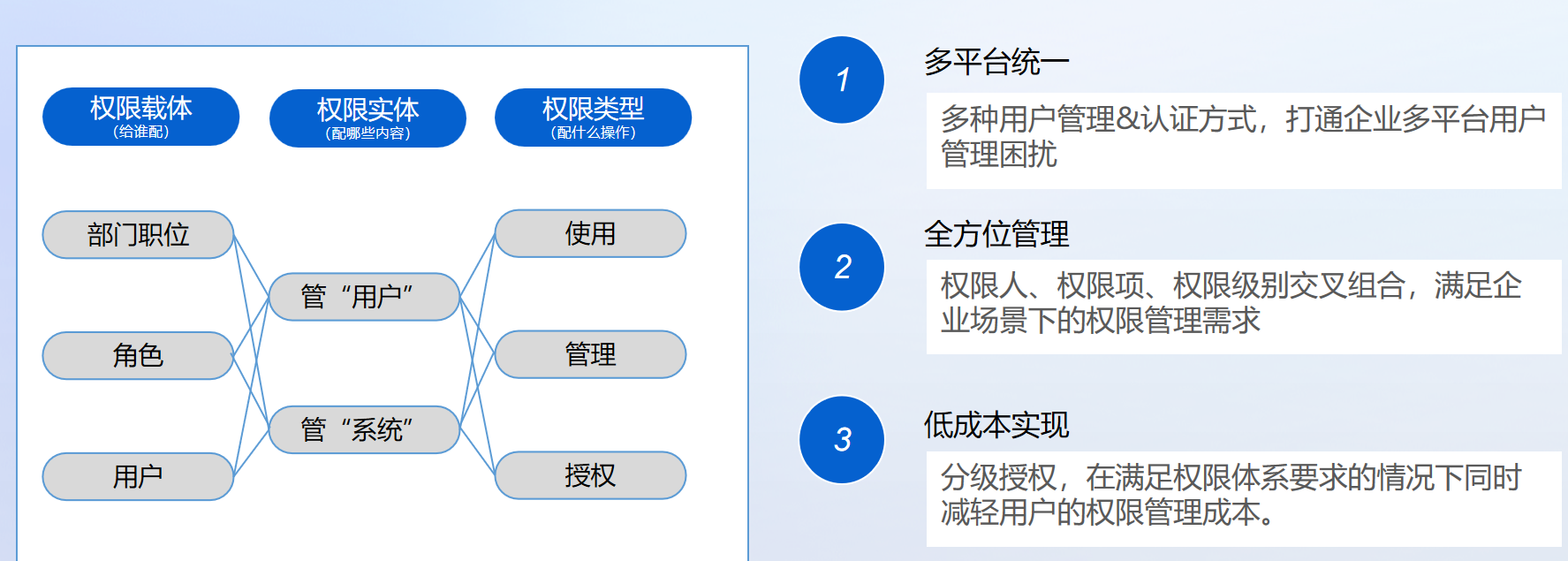

7. 企业级权限管控,满足不同层级权限要求编辑

定时任务模块权限说明如下:

| 文档 | 说明 |

|---|---|

| 数据连接权限概述 | 拥有某数据连接的使用权限,次管登录后可使用该数据连接创建定时任务、管道任务、API任务等 拥有某数据连接的管理权限,次管登录后可在「管理系统>数据连接>数据连接管理」中,对该数据连接进行复制、重命名、修改、删除等操作 拥有某数据连接的授权权限,次管登录后可在「管理系统>权限管理」中,将该数据连接的相应权限分配给可管理的用户 |

| 数据平台使用权限 | 在 FineDataLink中,管理员希望将「数据开发>定时任务」、「数据管道」、「数据服务」、「库表管理」功能的使用权限分配给其他用户:

|

| 数据平台授权权限 | 超级管理员可以给予某个对象数据平台的授权权限,使该对象将成为一个次级管理员 次级管理员可以给下级成员分配「数据平台」下模块的使用权限 |

| 定时任务管理权限 | 为普通用户分配「定时任务」中指定的文件夹和定时任务的查看和编辑权限 |

| 定时任务授权权限 | 超级管理员可以给予某个对象「定时任务」的授权权限,使该对象将成为一个次级管理员 次级管理员可以给下级成员分配「定时任务」的管理权限,使他下级的成员可以查看和编辑定时任务 |